前言

ArceOS 是基于组件化思想构造、以 Rust 为主要开发语言、Unikernel 形态的操作系统。与传统操作系统的构建方式不同,组件是构成 ArceOS 的基本元素。

本实验指导从零开始,带领大家一步一步的完成 ArceOS 的构建过程。每一步都是一个小型实验,在前一步实验的基础上,以增加和扩展组件的方式,增强 ArceOS 的功能特性,最终形成一个功能相对完备的 Unikernel 操作系统。在实验过程中,我们主要采用 Rust 语言进行开发,探寻如何发挥这种新型语言的特点,实践构建操作系统的新模式和新方法。

第零章 史前时代 - 从开机到内核启动

在操作系统正式启动之前,计算机需要进行一系列的引导和初始化工作,从硬件加电开始,到 BIOS 自检,再到 BootLoader 启动,然后才会把计算机的控制权交给操作系统的内核(以下简称内核)。

本章将追踪这一过程,了解各个启动阶段所完成的工作,明确内核获得控制权必须符合的条件;然后基于 Rust 语言开发一个只包含一行代码的裸机程序,这将是我们实验的第一个内核版本,当观察到这行代码被执行时,证明我们的内核首次获得了计算机的控制权,它将从此开启自己的时代!

在此之前,我们首先需要为实验搭建开发和运行环境。

第一节 实验环境

基于 WSL2+Unbuntu22.04.2 LTS,在此基础上安装:

1、安装开发运行的依赖包

sudo apt install autoconf automake autotools-dev curl libmpc-dev libmpfr-dev \

libgmp-dev gawk build-essential bison flex texinfo gperf libtool \

patchutils bc zlib1g-dev libexpat-dev pkg-config libglib2.0-dev \

libpixman-1-dev libsdl2-dev git tmux python3 python3-pip ninja-build

2、Rust 开发环境

curl https://sh.rustup.rs -sSf | sh

cargo install cargo-binutils

3、Qemu 模拟器(RiscV64)

下载并编译针对 RiscV64 架构的模拟器:

git clone https://git.qemu.org/git/qemu.git --depth 1

cd qemu

./configure --target-list=riscv64-softmmu

make -j $(nproc)

编译后得到 build/qemu-system-riscv64,把它的路径加入当前用户环境变量文件 .bashrc,编辑 ~/.bashrc 文件(如果使用的是默认的 bash 终端),在文件的末尾加入几行:

# 请注意,/path/to 是 qemu 的父目录,应调整为实际的安装位置

export PATH=$PATH:/path/to/qemu/build

随后即可在当前终端执行 source ~/.bashrc,或者直接重启一个新的终端,使刚才的环境变量设置生效。

4、RiscV 工具集

实验中需要用到其中的 riscv64-unknown-elf-objdump 等调试工具。

sudo apt install binutils-riscv64-unknown-elf

5、FDT转换工具

用于把设备树的二进制格式 dtb 转换为可读文本的形式 dts。

sudo apt install device-tree-compiler

第二节 计算机启动过程和对内核的要求

计算机启动时,顺序引导 BIOS、BootLoader 和内核。我们的实验基于 RiscV64 架构 qemu 模拟器,它对应模拟了这一过程。

模拟器 qemu-riscv64 启动时,将会经历几个阶段:

-

程序寄存器 PC 首先被初始化为 0x1000 的地址;

-

地址 0x1000 处被 qemu 预先放置了一个 ROM,顺序执行其中包含的寥寥几行代码,PC 跳转到 0x8000_0000 地址;

-

地址 0x8000_0000 同样被 qemu 预先埋伏了 OpenSBI(后文简称 SBI),并且入口就在这个开始地址。SBI 由此处启动,进行一系列的硬件初始化工作,并提供一组基本的功能调用,为后面操作系统内核的启动准备好条件和环境;最后一步,SBI 从 M-Mode 切换到 S-Mode,并跳转到地址 0x8020_0000 继续执行;

-

地址 0x8020_0000 就是为内核准备的位置,只要我们把内核加载到此处,并且保证内核入口在开头,就能够获得计算机的控制权。

RiscV 体系结构及平台在很多方面都体现了设计上的简洁。RISC-V SBI 规范定义了平台固件应当具备的功能和服务接口,多数情况下 SBI 本身就可以代替传统上固件 BIOS/UEFI + BootLoader 的位置和作用,qemu-riscv64 模拟器同样参照模拟了这一情况,并且把 OpenSBI 集成到 qemu 工程内部。而对于 X86 等体系结构,qemu 仍是延用传统方式,即从内嵌 seabios 开始引导,经过 grub 等 BootLoader 的进一步准备,最后再启动操作系统内核。

总结一下,我们的目标是,让自己开发的内核等候在正确的位置上,并以正确的形式存在。具体来说满足以下要求:

-

内核被加载到 0x8020_0000 地址

- 这是 qemu 的职责,我们只需要指定正确的参数。

-

内核编译后的形式必须是 binary

-

Rust 编译器输出的默认执行程序格式是 ELF,这种格式需要被 ELF 加载器解析和加载。

-

显然,内核的上一级加载器 SBI 并不支持 ELF 功能,所以只能让编译出来的内核以原始 binary 形式提供。

至少目前 OpenSBI 还没有支持 ELF 的计划。但是确实存在一些其它的 BootLoader 支持这样的功能。

-

-

内核入口必须在 Image 文件的开头

- Rust 编译器默认情况下,会自己安排可执行程序文件的分段与符号布局。由于我们必须确保内核入口在最前面,所以需要通过自定义 LDS 文件的方式,控制内核 Image 文件的布局。

- 后面的实验将会用到下面的 LDS 文件 linker.lds:

OUTPUT_ARCH(riscv) BASE_ADDRESS = 0x80200000; ENTRY(_start) SECTIONS { . = BASE_ADDRESS; _skernel = .; .text : ALIGN(4K) { _stext = .; *(.text.boot) *(.text .text.*) . = ALIGN(4K); _etext = .; } ... }-

有两个地方需要注意:

-

首先是把代码区 .text 作为第一个 section,并且其中 *(.text.boot) 在 *(.text .text.*) 之前,后者是代码默认情况下所属的 section 属性。将来我们把内核入口的代码标记在 .text.boot 区域中,就可以确保它会最早被执行。

-

其次起始地址 BASE_ADDRESS 是 0x8020_0000,正是内核的运行地址,这样就可以把内核的链接地址和运行地址一致起来。如果它们不一致,基于绝对寻址方式的指令将无法正常运行,进而导致内核崩溃。将来当我们启用分页机制之后,会把这个地址固定改成对应的虚拟地址 0xffff_ffc0_8020_0000。直观看来,这个虚拟地址相对物理地址存在一个偏移量 0xffff_ffc0_0000_0000,这个偏移的名字是 PHYS_VIRT_OFFSET,将来它会在虚实地址转换中发挥重要作用,后面第二章第一节会介绍这个偏移量是如何得出的。

注:如果此时就把 BASE_ADDRESS 设置为 0xffff_ffc0_8020_0000 或者其它的什么值,似乎程序最初也可以正常运行一部分代码。主要原因是,内核启动早期的那些汇编指令,通常会被有意保持为相对寻址,即它们是位置无关指令,所以 BASE_ADDRESS 对它们不起作用。但是相对寻址的地址范围受到限制,我们不能要求内核完全采用这种寻址方式,通常只是要求在启用分页之前的指令必须是相对寻址方式。

LDS 中还有一些其它的关键信息,在后边章节再详细介绍。

完整的 linker.lds 文件见 附录A。可以在 arceos 根目录下预先建立这个文件,第四节中会用到它。

-

第三节 内核第一行代码

现在我们开始动手用 Rust 编写内核的第一个版本 v0.1。虽然它只包含一行代码,但是当我们观测到这行代码被执行时,就意味着计算机经过漫长的启动,终于把系统控制权交到我们手里,在此之后就是 ArceOS 内核的 ShowTime!

首先建立工作目录 arceos,以后我们将把它作为根目录,逐步建立组件工程,同时维护一些对编译、运行进行支持的配置和脚本。

在工作目录 arceos 中,建立第一个工程 axorigin,默认是一个基于 Rust STD 标准库的 "Hello, World!" 可执行应用程序。

mkdir arceos

cd arceos

cargo new axorigin

按上述步骤建立的应用程序,原本预期会在 Linux 上编译和运行。程序入口 main 函数并非真正的程序入口,真正的入口其实是命名为 _start 的函数,Rust 编译器会结合工具链及 Linux 内核的要求生成 _start 函数的框架,在完成一些必要的运行前准备工作后,再调用 main 函数。此外,打印输出的功能也需要通过调用 Rust STD 标准库去申请 Linux 的系统调用服务。

这种默认生成的程序显然不符合我们的需要,我们要开发的程序是操作系统而不是应用。操作系统本身就是一种基于硬件的裸机程序(baremental)。对于裸机程序,配套的 STD 库是不存在的,也无法指望 Rust 编译器为我们生成 _start 函数,我们需要自己定义 _start 函数,并通过直接管理硬件资源来满足自身及上层应用的需求。

清空 main.rs,建立内核程序入口框架。

#![no_std]

#![no_main]

#[no_mangle]

#[link_section = ".text.boot"]

unsafe extern "C" fn _start() -> ! {

core::arch::asm!(

"wfi",

options(noreturn)

)

}通过 no_std 和 no_main 告诉 Rust 编译器,程序自定义 _start 入口,不需要 main 函数和标准库支持。

同时,对 _start 标记两个属性:

-

#[link_section = ".text.boot"]:如上节所说,要求编译器把 _start 函数代码放置在 Image 文件的开头,这样当内核被加载后,入口就是第一行指令。

-

#[no_mangle]:要求编译器保持 _start 函数名称不变。这个入口符号名称在链接过程中是必须存在和可见的,所以必须阻止编译器对 _start 这个符号名称进行混淆。

_start 中当前只有唯一的一行代码 wfi,后面在 qemu 启动时,我们将监控这行代码是否被执行到。

现在尝试在工作目录 arceos 下编译 axorigin 这个工程,需要输入额外的参数:

cargo build --manifest-path axorigin/Cargo.toml \

--target riscv64gc-unknown-none-elf --target-dir ./target --release

注意:必须显式指定 riscv64gc-unknown-none-elf 这个 target,告诉 Rust 编译器我们的编译目标是 RiscV64 架构的裸机程序。

此时可能会收到下面的错误信息:

error[E0463]: can't find crate for `core`

|

= note: the `riscv64gc-unknown-none-elf` target may not be installed

= help: consider downloading the target with `rustup target add riscv64gc-unknown-none-elf`

... ...

我们可以参照提示中的命令去下载和安装 target。

但这里提供另一个解决的办法,在工作目录下直接放配置文件 rust-toolchain.toml,来定制符合我们要求的 Rust 工具链,

[toolchain]

profile = "minimal"

channel = "nightly"

components = ["rust-src", "llvm-tools-preview", "rustfmt", "clippy"]

targets = ["riscv64gc-unknown-none-elf"]

把 riscv64gc-unknown-none-elf 加入工具链的默认 target 列表;同时 channel = "nightly",因为后面会用到Rust 的一些实验特性。

再次编译,还是报错,这次的提示:

error: `#[panic_handler]` function required, but not found

根据 Rust 的设计,程序遇到不可恢复异常时将会中止运行,展开调用栈,把异常信息输出到屏幕。这个机制与底层操作系统有关,定义在 STD 标准库中。如前所述,我们没有现成的实现,所以只能自己给出定义。

增加模块文件 lang_items.rs,然后在 main.rs 中加入一行 mod lang_items; 引入该模块。

// axorigin/src/lang_items.rs

use core::panic::PanicInfo;

#[panic_handler]

fn panic(_info: &PanicInfo) -> ! {

loop {}

}现在采取最简单的方式:如果遇到不可恢复的异常,程序将会无限循环下去。后面章节实验中,我们将逐步完善这个处理机制。

再次编译,终于通过了!但是当前输出的是 ELF 格式,还不能在 qemu 中直接运行,先转为原始二进制格式:

rust-objcopy --binary-architecture=riscv64 --strip-all -O binary \

target/riscv64gc-unknown-none-elf/release/axorigin \

target/riscv64gc-unknown-none-elf/release/axorigin.bin

得到的 axorigin.bin 就是我们最初版本的内核 image 文件,先用 xxd 命令查看一下内容:

xxd -e target/riscv64gc-unknown-none-elf/release/axorigin.bin

00000000: 10500073 0000 s.P...

这个内核 image 只有 6 个字节,对照 RiscV 指令手册,最前面的四个字节正是 wfi 的指令编码。这个结果有点意外,我们在前面做的一系列考虑和具体工作,在 Rust 看来,只有那一行代码是有意义的;就连 Rust 自己要求实现的 panic_handler 最终也被它忽略了:-)。不过这个内核文件对我们下面的实验已经足够了。

终于到了运行时刻!用 qemu 运行一下:

qemu-system-riscv64 -m 128M -machine virt -bios default -nographic \

-kernel target/riscv64gc-unknown-none-elf/release/axorigin.bin \

-D qemu.log -d in_asm

成功!屏幕输出了 OpenSBI 的启动信息。但是对我们的内核来说,目前还什么事都没有干,自然不会有输出。

现在 qemu 处于等待状态,通过输入 ctrl+a x 退回到 shell。具体操作:先按 ctrl + a,再按 x 键。

查看本地即当前目录,发现多出一个 qemu.log。

执行 qemu 时的最后一行参数让 qemu 模拟器记录了它执行过的代码序列,我们只需要关注日志文件的最后:

----------------

IN:

Priv: 1; Virt: 0

0x80200000: 10500073 wfi

0x80200004: 0000 illegal

qemu 在执行过程的最后阶段,到达了预设的内核入口地址 0x8020_0000,并且执行的正是我们安排的 wfi 指令。这证明:我们之前的努力获得了成功,从此时起,计算机(模拟器)的控制权就落入我们内核的手中,后面将通过一步步的工作逐渐增强完善内核的功能。

第四节 编译与运行环境

我们成功完成了第一个内核版本的编译和运行实验,但是前面命令输入的过程太过繁琐了。下面通过建立一个 Makefile来简化输入工作。

完整的 Makefile 内容见附录 B。

把 Makefile 放到工作目录 arceos 之下,它定义了一些快捷操作:今后执行 make 就可以编译内核,或者直接执行 make run 来完成编译+运行。

尝试在工作目录下测试以下make命令的有效性。

make

make run

make clean

执行 Makefile 时可能遇到的问题:

(1) 如果在本地创建 Makefile,直接拷贝上面 Makefile 的内容,执行 make 时有可能遇到下面的错误:

Makefile:xxx: *** missing separator. Stop.

原因:recipe 必须以 TAB 进行缩进,但当拷贝时有可能拷贝进来的是空格。例如 Makefile 文件的第17行等等。

解决办法:把各种缩进统一替换为 TAB。

(2) 如果第二节中没有在 arceos 根目录下创建 linker.lds,就会报如下错误:

= note: rust-lld: error: cannot find linker script XXX/arceos/linker.lds

原因:Makefile 导出了环境变量 RUSTFLAGS,通过它通知 Rust,在链接时使用我们自定义的linker.lds 控制 Image 布局。在上一节,我们虽然漏掉了这一步骤,但是结果依然是正常的。原因大家已经看到了,当前的 Image 即 axorigin.bin 只包含一条指令,有无布局文件对结果毫无影响。今后随着代码的增加,LDS 文件将会起到关键作用。

解决办法:参照附录 A 在工作目录下建立 linker.lds。

最后看一下我们工作目录的构成情况:

.

├── axorigin

│ ├── Cargo.toml

│ └── src

│ ├── lang_items.rs

│ └── main.rs

├── LICENSE

├── linker.lds

├── Makefile

├── README.md

└── rust-toolchain.toml

第五节 Unikernel 与组件化概念

ArceOS 是基于组件化思想的,从 Unikernel 形态起步的操作系统。

在本章结束之前,我们就来讨论一下 Unikernel 与组件化这两个基本的概念。为我们后面的工作建立一个基础。

Unikernel

Unikernel 是操作系统内核设计的一种架构(或称形态),从下图对比可以看出它与其它内核架构的显著区别:

Unikernel 相对其它内核架构有三个特点:

- 单特权级:应用与内核都处于同一特权级 - 即内核态,这使得应用在访问内核时,不需要特权级的切换。

- 单地址空间:应用没有单独的地址空间,而是共享内核的地址空间,所以在运行中,也不存在应用与内核地址空间切换的问题。

- 单应用:整个操作系统有且仅有一个应用,所以没有多应用之间隔离、共享及切换的问题。

所以相对于其它内核架构,Unikernel 设计实现的复杂度更低,运行效率相对较高,但在安全隔离方面,它的能力最弱。Unikernel 有它适合的特定的应用领域和场景。

ArceOS 选择 Unikernel 作为起步,希望为将来支持其它的内核架构建立基础。本实验指导正是对应这一阶段,从零开始一步一步的构建 Unikernel 形态的操作系统。Unikernel 本身这种简化的设计,可以让我们暂时忽略那些复杂的方面,把精力集中到最核心的问题上。

组件化操作系统

组件是预构建的、可以复用的、封装特定功能的独立实体。组件的内部功能对外不可见,外部只能通过它公开的接口与之通信。

现在我们把组件化思想应用到操作系统的构建实践中,组件是构造操作系统的最基本元素(Building Block),参与操作系统构建的所有功能部件,包括底层的系统引导与硬件封装,中层的各种子系统核心功能,上层的驱动以及服务,甚至内嵌到 Unikernel 中的应用,全部都是组件。

构建操作系统的过程大致可以分为两步:第一步是基于经验与实践,不断提炼组件,以建立基本的组件仓库;第二步是从仓库中选择适当的组件以适当的方式进行组合,形成目标操作系统。在我们的实验中,这两步是不断重复,反复迭代的过程。

在 Rust 开发中,组件 $\approx$ crate,在之后的内核开发实验中,将以构建 crate 的方式来构建组件,并将主要通过 dependencies+features 的方式组合组件,构造目标系统。

当本实验指导书的所有实验完成后,会形成如下图所示的组件化的操作系统:

本章总结

这一章我们学习了从计算机启动到进入内核的过程;建立了实验环境,并且实现了一个仅包含一行代码的最小内核。然后我们了解了 Unikernel 和组件化的基本概念,为后面的工作建立了基础。

从下一章开始,我们将会以组件化的方式,逐步的扩展这个 Unikernel 内核的功能与特性。

第一章 Hello, ArceOS! - 内核启动和组件诞生

通过前面一章的工作,我们已经构建了只包含一条指令的内核。这一章将会以此为起点,让内核完成启动和初始化工作,并且以向屏幕输出信息的方式宣告"内核启动成功"。在此基础上,我们将按照分层原则,把内核分裂为两个组件:管理硬件的基础组件和反映业务逻辑的应用组件,再把这两个组件重新组合为内核。这个分裂又重组的工作,当前看来或许无聊可笑,但在将来会逐渐体现出它的意义,这一步将是以组件化方式构造操作系统内核的开始,后面我们会以重用性为目标,提炼总结组件形成仓库,并不断寻找更好的组件管理和组合方式。

下面,先来看一下在最初的启动阶段,内核需要完成哪些工作。

第一节 内核启动

各种操作系统内核在最初启动时,通常都需要完成以下的几项工作:

- 清零BSS区域

- 保存一些必要的信息

- 启用内存分页

- 设置中断/异常向量表

- 建立栈以支持函数调用

- ... ...

每一项初始工作都具有特定的作用,并且与后续的工作相关。

这一节作为起步阶段,首先完成第 1 步和第 5 步,其它工作项暂时忽略,我们将在扩展对应的内核功能时,再回头进行补充。

第1步 - 清零 BSS 区域

BSS 是构成内核 Image 的一个特殊的数据区,编译器会把程序中未显式初始化的全局变量放到这个区域,这些全局变量默认值都应当是零。但是编译器本身并不执行 BSS 清零工作,这个通常是 ELF 加载器的工作。对于我们正在开发的内核,既然没有其它程序替我们完成,那就只好自己对 BSS 区域清零。

第5步 - 建立栈以支持函数调用

建立栈支持函数调用之后,我们就可以脱离晦涩的汇编语言,进入 Rust 的编程世界,利用 Rust 高级语言提供的各种先进特性实现内核功能。作为 Unikernel 内核,应用与内核都会使用这同一个栈,所以我们直接预分配 256K 的大栈空间,减少将来因栈溢出而带来的困扰。

现在我们就在 axorigin 中引入引导模块 boot,实现上面的两步:

// axorigin/src/boot.rs

#[no_mangle]

#[link_section = ".text.boot"]

unsafe extern "C" fn _start() -> ! {

// a0 = hartid

// a1 = dtb

core::arch::asm!("

la a3, _sbss

la a4, _ebss

ble a4, a3, 2f

1:

sd zero, (a3)

add a3, a3, 8

blt a3, a4, 1b

2:

la sp, boot_stack_top // setup boot stack

la a2, {entry}

jalr a2 // call rust_entry(hartid, dtb)

j .",

entry = sym super::rust_entry,

options(noreturn),

)

}从 _start 入口 开始,上面这段汇编代码分为三个部分:

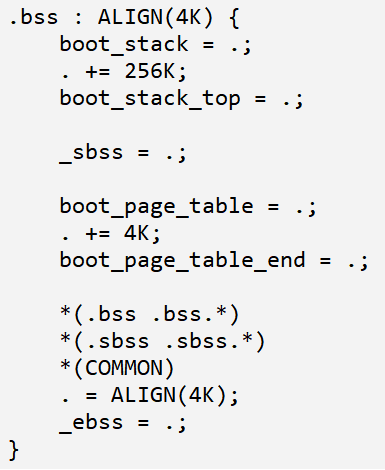

第 8~15 行:实现了 BSS 清零,BSS 区域的起止地址是 _sbss 和 _ebss,都定义在 linker.lds 中的 .bss 段中,符号可以被汇编直接引用。

第 17 行:初始化寄存器 sp,指向栈空间的最高地址 - 即栈底位置 boot_stack_top,该符号同样是定义在 linker.lds 文件的 .bss 中。如上图,在 .bss 段的开头,预留了 256K 的空间,并且 boot_stack_top 是空间的最高地址。另外,需要注意的是,这段栈空间并不包含在由 _sbss 和 _ebss 标记的范围内,因为栈不需要预先初始化。

第 25 和 26 行:在栈准备好的情况下,首次进入 Rust 函数 rust_entry。

先通过 la 指令取得 rust_entry 的入口地址,然后通过 jalr 调用该地址。按照 RiscV 规范,a0 到 a7 寄存器分别作为函数调用的前 8 个参数,当下只有 a0 和 a1 是有效的。这两个寄存器由上一级引导程序 SBI 设置,a0 保存了 HartID,也就是当前 cpu 核的硬件 ID;a1 则指向了一块内存区,其中保存的是描述底层平台硬件信息的设备树,即 dtb。

从上面的那段汇编代码可以看出,内核从启动到调用 Rust 入口函数过程中,没有使用过 a0 和 a1。如果在这个过程中必须使用它们,就必须先暂存它们的值,然后在调用 rust_entry 前恢复回来。这个就是本节开始时,提到的第 2 项任务,将来会看到这种处理的必要性。

最后,看看函数 rust_entry 的定义:

// axorigin/src/main.rs

#![no_std]

#![no_main]

#![feature(asm_const)]

mod lang_items;

mod boot;

unsafe extern "C" fn rust_entry(_hartid: usize, _dtb: usize) {

core::arch::asm!(

"wfi",

options(noreturn)

)

}目前 rust_entry 还干不了任何事,所以仍然调用 wfi 指令。注意它的两个参数 _hartid 和 _dtb,就是通过 a0 和 a1 寄存器传入的,暂时还用不到它们,但在将来它们会发挥重要作用。

用 make run 编译并执行,然后打开 qemu.log 并跳到末尾,查看从 0x80200000 开始直到 0x80200034 这段范围执行的指令序列,确认它们与我们编写的汇编代码等效。

在 qemu.log 中看到的指令,在形式上与我们编写的汇编指令有一点出入。 主要是因为我们用了一些伪指令,大家可通过 RiscV ASM 手册,查阅这些伪指令与实际指令的对应关系。

第二节 SBI 功能调用

到目前为止,我们还看不到内核的输出信息,只能通过查看 qemu 跟踪日志,确认工作成果。现在是实现打印输出的时候了!

有两个办法可以让内核支持 console,一是通过管理 Uart 串口设备进行输出,二是直接调用 OpenSBI 提供的功能。前一个方式需要自己实现驱动,但目前我们连最基础的内存管理都未能完成,缺乏实现驱动的条件;所以决定采用第二个办法。

前面一章提到,OpenSBI 提供了一系列功能调用,可以通过调用号去请求 SBI 为我们完成部分工作。查阅 OpenSBI 文档,发现功能调用 console_putchar 具有打印输出一个字符的能力,正可以作为输出功能的基础。然后从 crate.io 中,我们找到了 sbi-rt 这个现成的库,它封装了对 sbi 功能调用的各种方法。现在就使用它来实现 console 模块。

// axorigin/src/console.rs

pub fn putchar(c: u8) {

#[allow(deprecated)]

sbi_rt::legacy::console_putchar(c as usize);

}

pub fn write_bytes(bytes: &[u8]) {

for c in bytes {

putchar(*c);

}

}在 Cargo.toml 中,引入对 sbi-rt 的依赖。

// axorigin/Cargo.toml

[dependencies]

sbi-rt = { version = "0.0.2", features = ["legacy"] }

把 mod console 引入 main.rs,把 wfi 指令替换为调用字符串输出。

mod console;

unsafe extern "C" fn rust_entry(_hartid: usize, _dtb: usize) {

console::write_bytes(b"\nHello, ArceOS!\n");

}通过 make run 运行,终于在屏幕上看到了输出 “Hello, ArceOS!”。

仅仅支持输出字符串不方便,下面来进一步支持类似 print 的变参输出方式。

首先定义一个代表 Console 的全局变量,实现 Write 这个 Trait:

// axorigin/src/console.rs

use core::fmt::{Write, Error};

struct Console;

impl Write for Console {

fn write_str(&mut self, s: &str) -> Result<(), Error> {

write_bytes(s.as_bytes());

Ok(())

}

}

pub fn __print_impl(args: core::fmt::Arguments) {

Console.write_fmt(args).unwrap();

}当我们对 Console 调用 write_fmt(...) 时,Rust 库会帮助处理变参,我们只需要实现 write_str(...) 这个 Trait 的方法就可以了。

然后,提供两个宏定义 ax_print! 和 ax_println! 封装输出功能:

// axorigin/src/console.rs

#[macro_export]

macro_rules! ax_print {

($($arg:tt)*) => {

$crate::console::__print_impl(format_args!($($arg)*));

}

}

#[macro_export]

macro_rules! ax_println {

() => { $crate::print!("\n") };

($($arg:tt)*) => {

$crate::console::__print_impl(format_args!("{}\n", format_args!($($arg)*)));

}

}最后,在 axorigin 中调用 ax_println! 宏测试一下,删除 console::write_bytes(...) 那一行,替换为 ax_println! 输出:

// axorigin/src/main.rs

unsafe extern "C" fn rust_entry(_hartid: usize, _dtb: usize) {

let version = 1;

ax_println!("\nHello, ArceOS!");

ax_println!("version: [{}]", version);

}通过 make run 编译运行,看到作为变参的 version 信息输出。显示如下:

Hello, ArceOS! version: [1]

目前只能支持 Rust 基本类型,等下一章支持动态内存分配之后,我们再进一步测试对复杂集合类型的输出功能。

第三节 应用组件与硬件抽象组件

从本节开始,我们将开启组件化构造操作系统内核的旅程。

与传统构造内核的方法不同,组件化构造内核包括两个部分:一是建立一个组件仓库,其中的组件都具有高度的功能内聚性和可复用性;二是建立一种管理、选择和组合组件的方法与机制。在二者的基础上,我们就可以根据需要,基于组合组件的方式来构建内核。

接下来,我们就对应上面所述的两个部分,分两个步骤进行实验。

第一步:对当前版本的单一内核进行分解,形成最初的组件仓库。

当前内核虽然是 Unikernel 形态,按照功能仍然可以分成系统和应用两层。

- 系统层:迄今为止,我们进行的大部分工作都可以归纳到系统层,大多是针对硬件平台的操作,包括启动模块 boot,控制台模块 console 等等。这些模块的共同特点:对外提供一个抽象的硬件操作接口,内部则封装了针对 RiscV 体系结构和具体硬件的操作。我们希望把上述接口明确固定下来,形成一个稳定的硬件抽象层 Hardware Abstract Layer(简称 HAL)。以 HAL 分界,实现上下层组件的解耦,方便我们将来对其它体系结构及平台的支持工作。

- 应用层:目前应用层的工作仅仅是调用 console,向屏幕输出 Hello 信息。我们要把 rust_entry 框架从应用中分离出去,因为那些属于系统层的功能。

基于这样的层次划分,我们就分解出最初的两个组件 axhal 和 axorigin。其中,axorigin 继承了原始内核工程的名字,但它的身份已经降级成为一个应用组件,将来必须与 axhal 等系统组件配合来构成完整的 Unikernel 系统。

-

axhal 组件

-

封装系统层的模块,从外部形式看,它是一个 lib 形式的 crate。但是从启动角度,由于它的 boot 模块包含了内核的 _start 入口,其实是首先运行的,然后才会去启动应用组件。看一下这个 crate 的根模块 lib.rs 和 Cargo.toml:

// axhal/src/lib.rs #![no_std] #![no_main] mod lang_items; mod boot; pub mod console; unsafe extern "C" fn rust_entry(_hartid: usize, _dtb: usize) { extern "C" { fn main(hartid: usize, dtb: usize); } main(_hartid, _dtb); } // axhal/Cargo.toml [package] name = "axhal" version = "0.1.0" edition = "2021" See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html [dependencies] sbi-rt = { version = "0.0.2", features = ["legacy"] } -

组件 axhal 继承了上一版本内核几乎所有的模块,以及 rust_entry 框架,只是把直接调用 console 进行打印的代码,替换成一个外部函数 main,这个 main 函数就是新的应用组件 axorigin 的主函数,其中包含 console 打印。这里可能会产生一个疑问,为什么需要通过 extern ABI 这种外部函数的形式去调用?而不能以引入依赖 crate 的方式去调用?后面会说明这一原因。

-

-

axorigin 组件

-

前面提到了,这个组件只是继承了原来内核工程的名字,目前已经退化成一个应用组件。与组件 axhal 相应的,从外部看,axorigin 具有 main.rs 根模块,形式上就是一个 binary crate;但是它自身是无法运行的,需要等待 axhal 组件启动它。

-

来看一下 axorigin 当前的 main.rs 实现:

-

#![no_std] #![no_main] use axhal::ax_println; #[no_mangle] pub fn main(_hartid: usize, _dtb: usize) { let version = 1; ax_println!("\nHello, ArceOS!"); ax_println!("version: [{}]", version); } -

主体就是一个 main 函数,正对应 axhal 组件在最后阶段要调用的函数,main 是所有应用类型组件的入口。

这个 main,与我们基于 Linux/Windows 平台进行应用编程时写的 main,其实并无关系,上面

#[no_main]已经说明了这一点。这里起这个名字,只是为了适应编程习惯。 -

-

目前,应用组件 axorigin 在 main 函数中要实现的逻辑非常简单,但是它为我们建立了基本的 Unikernel 应用框架;将来在开发 Unikernel 应用时,只需要按此方式创建一个应用组件,并在 main 函数中实现业务逻辑即可。应用逻辑开发与系统功能的实现从此分离。

-

-

第二步:对现有的两个组件进行组合,形成可以运行的内核。

既然两个组件都是 Rust crate 的形式,最简单的组合方式,自然就是利用 Cargo 工具提供的 denpendencies 依赖机制进行连接组合。

来看 axorigin 的 Cargo.toml:

[package]

name = "axorigin"

version = "0.1.0"

edition = "2021"

# See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html

[dependencies]

axhal = { path = "../axhal" }

建立应用组件 axorigin 对 axhal 的依赖之后,Cargo 就可以自动为我们组合组件构造出内核。

用 git show --stat 比较当前基于组件化的版本与上一版本在代码方面的变化:

axorigin/Cargo.toml | 2 +-

axorigin/src/main.rs | 8 +++-----

{axorigin => axhal}/src/boot.rs | 0

{axorigin => axhal}/src/console.rs | 0

{axorigin => axhal}/src/lang_items.rs | 0

axhal/Cargo.toml | 9 +++++++++

axhal/src/lib.rs | 13 +++++++++++++

7 files changed, 26 insertions(+), 6 deletions(-)

运行 make run 测试,屏幕输出没有变化。

Hello, ArceOS! version: [1]

但是我们已经步入了组件化构造内核的进程中。

在本节结束之前,解释一下之前的问题:为什么在启动过程中,组件 axhal 必须通过 extern ABI 的方式调用组件 axorigin 的 main 函数。

从图中可以看到,两个组件之间存在相互调用的关系,启动过程中 axhal 调用 axorigin 的 main 函数;运行过程中 axorigin 作为应用需要调用系统组件 axhal 的各种功能。既然 axorigin 已经通过 Cargo.toml 对 axhal 建立了依赖,那么另一个方向的依赖就不成立了,否则就会导致循环依赖。因此只好在启动过程中,采用 extern ABI 的方式调用 main 函数。

在我们将来构造内核的实验中,循环依赖将会是一个比较麻烦的问题。在第三章里,将会引入一个特殊的组件 crate_interface 专门用于处理循环依赖,本质上它仍然是基于 extern ABI,但是基于该组件提供了一种 Rusty 风格的调用方式,这样来做,代码的可读性更好,同时可以有效减少编程出错的概率。

第四节 组件测试和模块测试

Rust 工具链本身对测试的支持很方便,下面将基于这一有利条件,对内核的组件和模块进行功能测试验证。组件测试相当于 crate 级的测试,直接在 crate 根目录下建立 tests 模块,对组件进行基于公开接口的黑盒测试;模块测试对应于单元测试,在模块内建立子模块tests,对模块的内部方法进行白盒测试。在 Makefile 中,预留了一个test 命令入口,用于启动上述测试。

我们需要注意一个容易忽略的事实,通过 make run 编译并运行内核,与通过 make test 编译并执行测试,这二者的编译和运行环境是截然不同的,前者的编译目标是 RiscV64 体系结构,并通过 qemu-riscv64 模拟器运行;后者则是针对本地的 x86_64 体系结构,在本地 Linux 上作为应用直接运行(Linux on x86_64 这应该是我们大多数人的本地开发环境)。因此,通过 Rust 工具链进行测试是有局限的,测试的功能与实际将要运行的功能可能存在差异,测试时还有可能需要一些 dummy 测试桩的辅助。我们需要清醒的保持这一认识,避免在后面的实验开发和测试中陷入困惑。

下面对现有的工程项目进行一些改造,满足测试的需要:

-

Makefile 中 test 命令

调用

cargo test启动测试:ifeq ($(filter $(MAKECMDGOALS),test),) # not run `cargo test` RUSTFLAGS := -C link-arg=-T$(LD_SCRIPT) -C link-arg=-no-pie export RUSTFLAGS endif test: cargo test --workspace --exclude "axorigin" -- --nocapture测试针对整个工程 workspace 下包含的所有组件,只是排除 axorigin 应用本身。我们希望测试用例中能够通过 println! 直接输出信息到屏幕,所以指定了

--nocapture参数。特别需要注意的是上面的 1~4 行,环境变量

RUSTFLAGS不能出现在make test的过程中,原因前面已经说了,测试时是基于 x86_64 的体系结构,这个环境变量却要求使用面向 RiscV64 的 linker.lds 链接脚本和参数。如果不注意这一点,就会出现如下的错误:= note: /usr/bin/ld: cannot represent machine `riscv' collect2: error: ld returned 1 exit status error: could not compile `axhal` (lib test) due to previous errorx86 工具链的链接器在解析 linker.lds 第一行时就发现错误,它不能识别

OUTPUT_ARCH(riscv),直接报错退出了。 -

工程 Workspace 级的 Cargo.toml

[workspace] resolver = "2" members = [ "axorigin", "axhal", ] [profile.release] lto = true以后增加新组件时,需要扩展 members 列表。

-

改造 axhal 组件的代码组织结构

组件 axhal 负责屏蔽体系结构的差异,所以它对

make test所要求的另类环境最为敏感。首先改造 crate 的 lib.rs:

// axhal/src/lib.rs #![no_std] #[cfg(target_arch = "riscv64")] mod riscv64; #[cfg(target_arch = "riscv64")] pub use self::riscv64::*; // axhal/src/riscv64.rs mod lang_items; mod boot; pub mod console; unsafe extern "C" fn rust_entry(_hartid: usize, _dtb: usize) { extern "C" { fn main(hartid: usize, dtb: usize); } main(_hartid, _dtb); }原来 lib.rs 只是针对 RriscV64 的实现,现在下移到 riscv64.rs 模块文件中;相应的,lang_items.rs、boot.rs和 console.rs 三个文件,也移到到目录 riscv64 下。这样只有当目标体系结构是 RriscV64 时,才会引用这些实现,因而执行测试时不会编译它们。

改造 axhal 的 Cargo.toml:

[target.'cfg(target_arch = "riscv64")'.dependencies] sbi-rt = { version = "0.0.2", features = ["legacy"] }把 [dependencies] 改成带体系结构条件的形式,避免在执行测试时引入 sbi-rt 这个无效引用。

用 git show --stat 看一下改造后的情况:

Cargo.toml | 10 ++++++++++

Makefile | 7 ++++++-

axhal/Cargo.toml | 2 +-

axhal/src/lib.rs | 15 ++++-----------

axhal/src/riscv64.rs | 10 ++++++++++

axhal/src/{ => riscv64}/boot.rs | 0

axhal/src/{ => riscv64}/console.rs | 0

axhal/src/{ => riscv64}/lang_items.rs | 0

8 files changed, 31 insertions(+), 13 deletions(-)

分别执行 make run 和 make test,验证我们的成果。

前者的输出没有变化,而执行后者时,显示如下:

cargo test --workspace --exclude "axorigin" -- --nocapture Compiling axhal v0.1.0 (/home/cloud/gitStudy/arceos_tutorial/axhal) Finished test [unoptimized + debuginfo] target(s) in 0.20s Running unittests src/lib.rs (target/debug/deps/axhal-0770fa3f3cc1ea75)

running 0 tests

test result: ok. 0 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

Doc-tests axhal

running 0 tests

test result: ok. 0 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

目前还没有写任何测试用例,测试框架只是空转一次。

下节开始,我们将使用测试用例来驱动内核的开发。

第五节 全局配置与同步支持

在本章的最后,增加几个常用工具组件,为后续的实验工作做一个准备。

-

全局配置组件 axconfig

创建组件 axconfig,主要用来提供全局的配置参数和一些常用的工具函数,它的 lib.rs 就如这样:

// axconfig/src/lib.rs #![no_std] pub const PAGE_SHIFT: usize = 12; pub const PAGE_SIZE: usize = 1 << PAGE_SHIFT; pub const PHYS_VIRT_OFFSET: usize = 0xffff_ffc0_0000_0000; pub const ASPACE_BITS: usize = 39; pub const SIZE_1G: usize = 0x4000_0000; pub const SIZE_2M: usize = 0x20_0000; #[inline] pub const fn align_up(val: usize, align: usize) -> usize { (val + align - 1) & !(align - 1) } #[inline] pub const fn align_down(val: usize, align: usize) -> usize { (val) & !(align - 1) } #[inline] pub const fn align_offset(addr: usize, align: usize) -> usize { addr & (align - 1) } #[inline] pub const fn is_aligned(addr: usize, align: usize) -> bool { align_offset(addr, align) == 0 } #[inline] pub const fn phys_pfn(pa: usize) -> usize { pa >> PAGE_SHIFT }在我们的实验中,页面 Page 采用最常见的 4096 字节。同时提供一组与对齐相关的工具函数。

后面我们会陆续加入更多的配置参数和工具函数。

可以在真正实现 align 相关函数之前,先写好测试用例,以测试驱动的方式开发该组件功能:

// axconfig/tests/test_align.rs use axconfig::{align_up, align_down, PAGE_SIZE}; #[test] fn test_align_up() { assert_eq!(align_up(23, 16), 32); assert_eq!(align_up(4095, PAGE_SIZE), PAGE_SIZE); assert_eq!(align_up(4096, PAGE_SIZE), PAGE_SIZE); assert_eq!(align_up(4097, PAGE_SIZE), 2*PAGE_SIZE); } #[test] fn test_align_down() { assert_eq!(align_down(23, 16), 16); assert_eq!(align_down(4095, PAGE_SIZE), 0); assert_eq!(align_down(4096, PAGE_SIZE), PAGE_SIZE); assert_eq!(align_down(4097, PAGE_SIZE), PAGE_SIZE); }上面是组件级的测试用例,直接放在 axconfig/tests 目录下,用于对组件公开接口的测试。

执行

make test,显示测试成功:Running tests/test_align.rs (target/debug/deps/test_align-087b60d36f414a97)

running 2 tests test test_align_down ... ok test test_align_up ... ok

test result: ok. 2 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

-

自旋锁 SpinRaw

在真正启动多任务和启用中断之前,内核一直处于纯粹的单线程执行状态,没有任何并发,自然也没有同步的问题,当前对于全局变量的修改是安全的。但是 Rust 不清楚这一点,所以我们需要先实现一个最初版本的自旋锁 SpinRaw,用它包装 mutable 全局变量,假装已经有了同步保护,但实际上它目前只是个空壳。

创建组件 spinlock,在模块 raw.rs 中实现 SpinRaw 类型。

// spinlock/src/lib.rs #![no_std] mod raw; pub use raw::{SpinRaw, SpinRawGuard}; // spinlock/src/raw.rs use core::cell::UnsafeCell; use core::ops::{Deref, DerefMut}; pub struct SpinRaw<T> { data: UnsafeCell<T>, } pub struct SpinRawGuard<T> { data: *mut T, } unsafe impl<T> Sync for SpinRaw<T> {} unsafe impl<T> Send for SpinRaw<T> {} impl<T> SpinRaw<T> { #[inline(always)] pub const fn new(data: T) -> Self { Self { data: UnsafeCell::new(data), } } #[inline(always)] pub fn lock(&self) -> SpinRawGuard<T> { SpinRawGuard { data: unsafe { &mut *self.data.get() }, } } }按照 Rust 要求,标记 SpinRaw 具有 Send 和 Sync 的标记 trait。

实现 lock 方法返回 SpinRawGuard,假装这个 guard 持有了锁,guard 是 RAII 的模式,当它释放即执行 drop 方法时自动解锁。目前没有实际解锁动作,直接忽略对 Drop trait 的实现。

然后我们为 guard 实现 Deref 和 DerefMut 两个 Trait,把它作为智能指针以方便直接访问 SpinRaw 包装变量的方法。

// spinlock/src/raw.rs impl<T> Deref for SpinRawGuard<T> { type Target = T; #[inline(always)] fn deref(&self) -> &T { unsafe { &*self.data } } } impl<T> DerefMut for SpinRawGuard<T> { #[inline(always)] fn deref_mut(&mut self) -> &mut T { unsafe { &mut *self.data } } }编写测试用例,验证对外公开的组件接口功能:

// spinlock/tests/test_raw.rs use spinlock::SpinRaw; struct Inner { val: usize, } impl Inner { const fn new() -> Self { Self { val: 0 } } fn set(&mut self, v: usize) { self.val = v; } fn get(&self) -> usize { self.val } } static SPIN: SpinRaw<Inner> = SpinRaw::new(Inner::new()); #[test] fn test_lock() { SPIN.lock().set(1); assert_eq!(SPIN.lock().get(), 1); }执行

make test测试,显示:Running tests/test_raw.rs (target/debug/deps/test_raw-70e610058ffa9914)

running 1 test test test_lock ... ok

test result: ok. 1 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

-

BootOnceCell

类似于上面情况,有些全局变量虽然需要设置,但是仅需要一次,之后就一直是只读状态,这属于延迟初始化的一种。

例如下一章马上要涉及的早期页表根目录 KERNEL_PAGE_TABLE,这个全局变量只需要初始化一次,但是负责初始化的是一个函数,没法在定义时直接调用,只能延迟初始化。那么就可以借助这个 BootOnceCell 来封装 KERNEL_PAGE_TABLE。

创建组件 axsync,在模块 bootcell.rs 中实现类型 BootOnceCell。

// axsync/src/lib.rs #![no_std] mod bootcell; pub use bootcell::BootOnceCell; // axsync/src/bootcell.rs use core::cell::OnceCell; pub struct BootOnceCell<T> { inner: OnceCell<T>, } impl<T> BootOnceCell<T> { pub const fn new() -> Self { Self { inner: OnceCell::new() } } pub fn init(&self, val: T) { let _ = self.inner.set(val); } pub fn get(&self) -> &T { self.inner.get().unwrap() } pub fn is_init(&self) -> bool { self.inner.get().is_some() } } unsafe impl<T> Sync for BootOnceCell<T> {}注意两点:

- 我们以 Rust 库提供的 OnceCell 为基础进行实现,比较简便。

- 顾名思义,BootOnceCell 的那一次初始化调用必须在 Boot 阶段,即单线程环境下完成,之后就变成了只读变量,这样再启用多线程也没有问题。但如果初始化操作是在启用多线程或中断之后再进行,就是不安全的。一定注意这个调用时机。

BootOnceCell 是对 lazy_static 的替代实现。

对应的测试用例如下:

// axsync/tests/test_bootcell.rs use axsync::BootOnceCell; static TEST: BootOnceCell<usize> = BootOnceCell::new(); #[test] fn test_bootcell() { assert!(!TEST.is_init()); TEST.init(101); assert_eq!(TEST.get(), &101); assert!(TEST.is_init()); }执行

make test测试,显示:Running tests/test_bootcell.rs (target/debug/deps/test_bootcell-3224367d8bbd079d)

running 1 test test test_bootcell ... ok

test result: ok. 1 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

本章总结

这一章我们完成了内核的初始化,并且向屏幕输出了信息。在此基础上,我们建立了最早的组件仓库和组合组件的方式,现在有了分离的应用组件 axorigin 和第一个系统级组件 axhal,axhal 用于对底层体系结构和硬件的差异进行屏蔽。我们还在工程中引入了对组件和模块测试的支持,并为下一步内核的开发准备了几个最基础的组件。

下一章,我们将会针对操作系统内核的第一项重要功能 - 内存管理进行实验。

第二章 内存管理1 - 初始的地址空间和早期内存分配

内存管理是操作系统内核中最基础的功能,它几乎是其它所有功能得以运行的前提与支撑。因此,在内核启动的早期过程中,我们首先要建立内存管理方面的机制和功能,这通常包括两个部分:建立初始的地址空间和建立最初的动态内存分配机制。

第一节 基本概念 - 地址空间

地址空间是内核与应用的生存活动空间。内核或应用在运行中需要访问资源,主要包括三类资源:内存、I/O 端口以及中断编号(irq num)。具体到 RiscV 平台,前两类资源是统一进行编址的,它们在地址空间中由唯一的地址范围来标识;至于第三类 - 中断编号,本书不把它归入地址空间的范畴,我们将在第六章再来讨论。

对于 X86 体系结构,内存与 I/O 端口分别编址,需要通过不同的指令来访问这两类资源。

我们目前开发的内核是 Unikernel 形态,地址空间方面有其明显的特点:

- 只有单一的处于内核态的地址空间,内核与内嵌应用共用这一地址空间,不存在用户态进程空间(Unikernel其实连进程概念都没有)。

- 当内核刚启动时,这个地址空间是物理地址空间,空间布局由硬件平台所决定。

- 基于分页机制,我们可以在物理地址空间的基础上,新增虚拟地址空间,以获得更好的地址管理的灵活性。

CPU 有一个附属部件 MMU(Memory Management Unit),它的作用就是控制分页机制。MMU 默认是未启用分页的,所以内核启动时,直接看到的就是物理地址空间,并通过物理地址来访问资源,我们目前就正处在这个状态;然后内核创建页表,自定义虚拟地址空间的布局,然后通过设置 MMU 启用分页,分页启用后,虚拟地址空间开始发挥作用,它向内核遮蔽了真实的物理地址空间,内核看到的是经过精心映射后的虚拟地址空间,通过虚拟地址访问资源。虚拟地址空间中的各个地址范围,一部分会被实际映射到物理空间的某些地址区间上,而大部分会暂时或者永远处于未映射的状态,直接访问时将导致 Page Fault 异常。

物理地址空间是硬件平台生产构造时就已经确定的,而虚拟地址空间则是内核可以根据实际需要灵活定义和实时改变的,这是将来内核很多重要机制的基础。按照近年来流行的说法,分页机制赋予了内核“软件定义”地址空间的能力。

以下就针对我们的实验平台 qemu-riscv64-virt,进行分析和实验。

物理地址空间由硬件平台在生产时决定,通常以 FDT(flattened device tree)的形式提供。对于 qemu-riscv64-virt 平台,我们可以通过如下方式导出它的 fdt 文件。

当运行 make run 时,在屏幕输出中可以看到 qemu 的执行命令行:

Running on qemu...

qemu-system-riscv64 -m 128M -smp 1 -machine virt -bios default

-kernel target/riscv64gc-unknown-none-elf/release/axorigin.bin -nographic

-D qemu.log -d in_asm

注意上图中显示的 qemu-system-riscv64 执行时的命令行,修改这行命令,在参数 "-machine virt" 后面追加 ",dumpdtb=virt.dtb"。如此,命令的执行效果就发生了改变,不再是启动模拟器,而是导出名为 virt.dtb 的 fdt 文件,然后就退出了。得到的 virt.dtb 还只是二进制格式,进一步用 dtc 工具把它转换成可读的文本形式。执行的命令如下:

# 在参数"-machine virt"之后, 增加 ",dumpdtb=virt.dtb",用于导出fdt文件的二进制格式dtb

qemu-system-riscv64 -m 128M -smp 1 -machine virt,dumpdtb=virt.dtb \

-bios default -kernel target/riscv64gc-unknown-none-elf/release/axorigin.bin -nographic

# 把二进制形式virt.dtb,转化为可读的文本形式

dtc ./virt.dtb -o ./virt.dts

注意:执行上面的命令行导出 fdt 时,一定要保留所有参数。fdt 中很多配置项的值由 qemu 根据参数来决定。例如,对于物理内存的大小,qemu 参数指定

-m 128M来模拟 128M 的物理内存,相应的 fdt 中描述的 memory 就是 128M。

现在查看 virt.dts 的内容,仅节选与下步实验密切相关的部分:

/dts-v1/;

/ {

#address-cells = <0x02>;

#size-cells = <0x02>;

compatible = "riscv-virtio";

model = "riscv-virtio,qemu";

... ...

memory@80000000 {

device_type = "memory";

reg = <0x00 0x80000000 0x00 0x8000000>;

};

... ...

soc {

#address-cells = <0x02>;

#size-cells = <0x02>;

compatible = "simple-bus";

ranges;

... ...

serial@10000000 {

interrupts = <0x0a>;

interrupt-parent = <0x03>;

clock-frequency = "\08@";

reg = <0x00 0x10000000 0x00 0x100>;

compatible = "ns16550a";

};

... ...

virtio_mmio@10001000 {

interrupts = <0x01>;

interrupt-parent = <0x03>;

reg = <0x00 0x10001000 0x00 0x1000>;

compatible = "virtio,mmio";

};

... ...

};

};

现在先跳过 fdt 其它细节,注意 memory、serial和virtio_mmio 三个设备的 reg 字段,该字段描述了对应设备在地址空间中占据的地址区间范围,区间由起始地址和长度组成,是包含四个 32 位数的序列。对序列的解析需要依赖 #address-cells 和 #size-cells,它们如同编程中的变量作用域一样,内层定义可以覆盖外层。上面的示例中,它们分别在根和 soc 两级出现,且数值都是 2,这说明区间起始地址由两个值组成,长度也由两个值组成,它们都是 64 位数。fdt 采用大端序表示数据,所以物理内存 memory 的地址范围从 0x8000_0000 开始,大小是 0x800_0000 即 128M,这与当初在命令行中指定的参数是一致的;串口 serial 从 0x1000_0000 开始,长度 256 字节;第一个 virtio_mmio slot 的地址区间从 0x10001000 开始,长度是 4096 字节即 1 页,后面按顺序排列了另外 7 个 virtio_mmio slot。

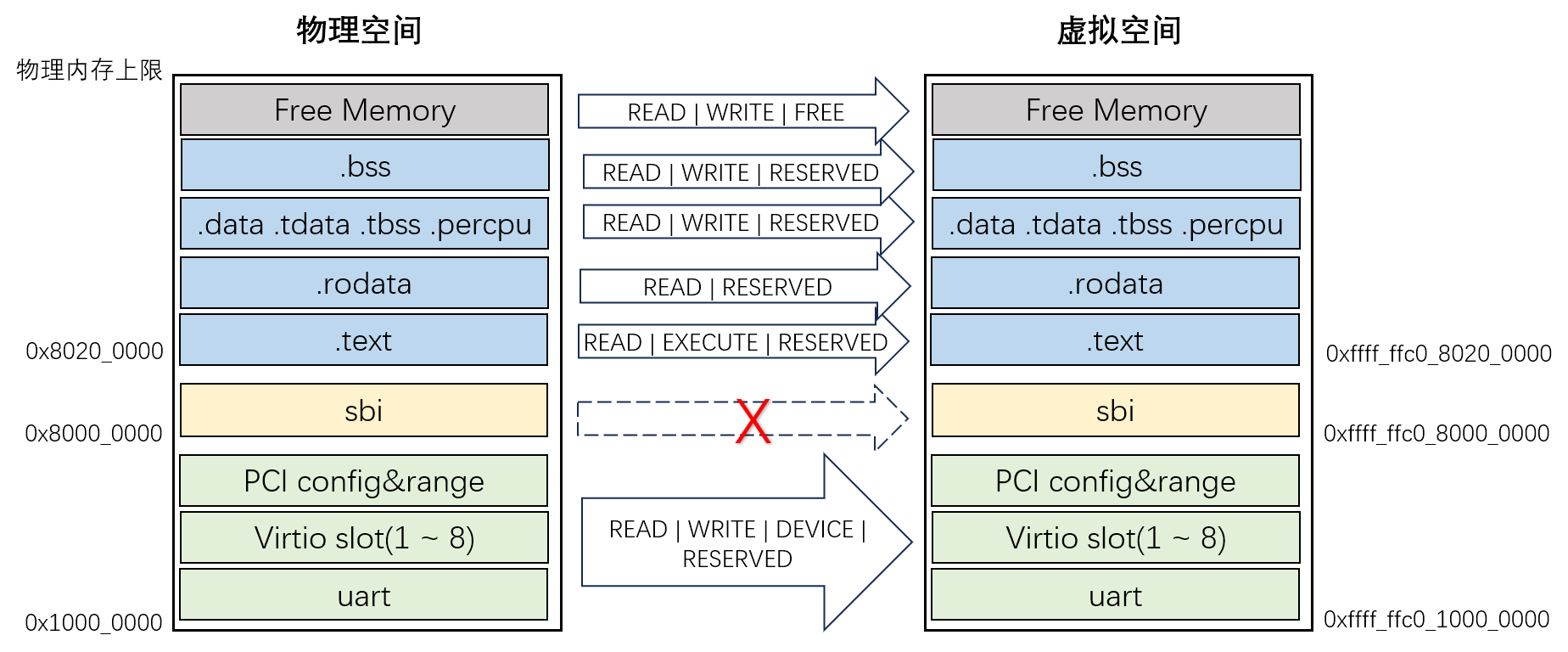

现在可以画出我们实验平台大致的物理地址空间布局了:

在第零章,我们提到需要把 SBI 放到物理内存开始的位置 0x8000_0000 地址处,这里就知道了该地址可以从 fdt 中得知。此外,通过 fdt,我们还知道了 qemu 实验平台上,各个设备所占用的 mmio 范围集中安排在物理空间的低地址范围内。其中 virtio mmio slots 是后面实验中操作 virtio 设备的基础信息,我们将在第九章再分析它们。本章暂时只关注内存管理,即先完成内存部分 - 0x8000_0000 之后的虚拟地址空间映射。

从第一章我们知道,内核最早启动时,a1 寄存器保存的就是 fdt 二进制数据块 dtb 的开始指针。这个数据块与我们在本节中导出分析的 fdt 内容完全相同。fdt 是内核获取硬件平台配置信息的主要途径。目前为止,我们只是人工查看导出的 fdt 信息,为内核开发提供基础信息。到下一章的最后一节,我们将为内核实现自动解析 fdt 的功能,让内核在运行中自动获取这些关键信息。

下面就来考虑建立虚拟地址空间的问题。

本章我们建立的虚拟地址空间只需要与物理空间形成简单的线性映射,并且只处理包含 SBI 和 Kernel 存储区的 1G 范围。如下图,虚拟地址范围 0xFFFF_FFC0_8000_0000 ~ 0xFFFF_FFC0_C000_0000 线性映射到物理地址范围 0x8000_0000 ~ 0xC000_0000。

线性偏移的好处是,只需要通过加减偏移运算,就能完成虚拟地址与物理地址之间的转换。这个线性偏移常量称为 PHYS_VIRT_OFFSET,相应的运算公式表示为:

VA = PA + PHYS_VIRT_OFFSET;

PA = VA - PHYS_VIRT_OFFSET;

当前实验中 PHYS_VIRT_OFFSET=0xFFFF_FFC0_0000_0000,与我们选择的分页机制方案 Sv39 有关。我们开发的内核是 64 位系统,最大可用的地址空间范围是 64 位;但是按照 RiscV 规范,Sv39 有效的虚拟地址范围被约束为最大 39 位,从 40 位往上那些未使用的位必须与第 39 位一致。也就是说,如果第 39 位是 1,从第 40 位向上全部填充 1,有效范围 0xFFFF_FFC0_0000_0000 ~ 0xFFFF_FFFF_FFFF_FFFF;如果第 39 位是 0,高位全部填充 0,那么有效地址范围就是从 0 到 0x3F_FFFF_FFFF。这两个范围正处于64位空间最高端和最低端这两头的位置。按照惯例,我们选择了高端的这个范围,把它作为内核本身的虚拟地址空间;低端的那个范围暂时预留,将来支持宏内核模式时,我们把它作为应用进程的虚拟地址空间。

下面开始基于 Sv39 方案,建立我们内核的分页机制。

第二节 分页机制 - 页表和页表项

本节先来建立分页机制的基本数据结构 - 页表和页表项,为后面正式启用分页做准备。

从根页表开始,每一级页表都占用一个内存页,关于内存页大小,我们采用最典型的 4096 字节。Sv39 是针对 64 位系统的分页方案,即页表项长度是 8 字节,所以每个页表包含 512 个页表项。页表作为多级嵌套结构,由页表 page_table 和页表项 page_table_entry 两种基本元素交替构成,它们符合如下的模式:

每个页表 page_table 对应一个内存页,每个页划分为 512 个页表项 page_table_entry;页表项 page_table_entry 由物理页帧号 pfn 和标志位组 flags 这两部分构成。根据标志位不同,页表项有三种情况:

- 空页表项:尚未与物理页建立映射;

- 指向下级页表:pfn 保存的是下级页表的物理页帧号,当进行地址映射时,需要递归到下一级页表继续处理;

- 指向最终页:这种是叶子页表项(leaf entry),它的 pfn 直接就保存着一个物理页或者大页的页帧号。

下面来看一下 flags 各个位的具体功能定义,这里部分参照了 Linux 对各个位的命名:

/*

* RiscV64 PTE format:

* | XLEN-1 10 | 9 8 | 7 | 6 | 5 | 4 | 3 | 2 | 1 | 0

* PFN reserved for SW D A G U X W R V

*/

const _PAGE_V : usize = 1 << 0; /* Valid */

const _PAGE_R : usize = 1 << 1; /* Readable */

const _PAGE_W : usize = 1 << 2; /* Writable */

const _PAGE_E : usize = 1 << 3; /* Executable */

const _PAGE_U : usize = 1 << 4; /* User */

const _PAGE_G : usize = 1 << 5; /* Global */

const _PAGE_A : usize = 1 << 6; /* Accessed (set by hardware) */

const _PAGE_D : usize = 1 << 7; /* Dirty (set by hardware)*/

const PAGE_TABLE: usize = _PAGE_V;

pub const PAGE_KERNEL_RO: usize = _PAGE_V | _PAGE_R | _PAGE_G | _PAGE_A | _PAGE_D;

pub const PAGE_KERNEL_RW: usize = PAGE_KERNEL_RO | _PAGE_W;

pub const PAGE_KERNEL_RX: usize = PAGE_KERNEL_RO | _PAGE_E;

pub const PAGE_KERNEL_RWX: usize = PAGE_KERNEL_RW | _PAGE_E;flags 从第 10 位往上是物理页帧号 pfn,而第 10 位是页表项的属性标志位。

第 0 位 V:页表项是否有效,当访问无效页面时,MMU 触发 Page Fault 之类的异常,这通常作为 Linux 等内核缺页加载的基本机制;

第 1~3 位 RWE:对映射后的页面是否分别具备读、写、执行权限,当越权访问时,MMU 触发 Access Fault 之类的异常,在 Linux 等内核实现中,可以基于该类异常实现 COW 写时拷贝;

第 4 位 U:表示这是用户页。由于实验内核是 Unikernel 形态,不存在用户态,所以这个位直接清零。

第 5 位 G:表示是全局页。这个位与 tlb 刷新有关。我们的 Unikernel 内核中,所有用到的页面都设置为全局页。

第 6~7 位 AD:分别表示 Accessed 访问过和 Dirty 被改写过。对于 Linux 等内核,通常是先把它们清零,如果运行过程中访问或改写了对应映射的页面,MMU 硬件会自动把它们置一,内核只要检查这两个位,就能知道是否发生过访问或改写的情况,这通常对页面置换策略有帮助。但是对我们的内核,没有涉及页面置换的问题,所以初始化时,只是简单的把它们都设置成一。

基于上述位,对外提供两个公开的复合标识。PAGE_KERNEL_RW 作为默认的地址映射标识,表示映射的页面存在并可以读写;PAGE_KERNEL_RWX 在此基础上增加执行权限。

实现一个新组件 page_table,首先包含上述标识定义,然后定义页表和页表项的数据结构和页表的初始化函数:

// page_table/src/lib.rs

#![no_std]

use axconfig::phys_pfn;

#[derive(Debug)]

pub enum PagingError {}

pub type PagingResult<T = ()> = Result<T, PagingError>;

const PAGE_PFN_SHIFT: usize = 10;

const ENTRIES_COUNT: usize = 1 << (PAGE_SHIFT - 3);

#[derive(Clone, Copy)]

#[repr(transparent)]

pub struct PTEntry(u64);

impl PTEntry {

pub fn set(&mut self, pa: usize, flags: usize) {

self.0 = Self::make(phys_pfn(pa), flags);

}

fn make(pfn: usize, prot: usize) -> u64 {

((pfn << PAGE_PFN_SHIFT) | prot) as u64

}

}

pub struct PageTable<'a> {

level: usize,

table: &'a mut [PTEntry],

}

impl PageTable<'_> {

pub fn init(root_pa: usize, level: usize) -> Self {

let table = unsafe {

core::slice::from_raw_parts_mut(root_pa as *mut PTEntry, ENTRIES_COUNT)

};

Self { level, table }

}

}第 14 行:页表项 PTEntry 是 64 位长度的数据项,后面会实现一些具体方法针对 pfn 和 flags 两个位域进行操作。

第 26~29 行:页表 PageTable 包括两个成员,level 是该页表所在的级别,根页表是 0,以此类推;table 数组对应页表包含的页表项序列。然后来看 init 初始化方法,以页表对应页面的物理地址为开始指针,构造页表项数组类型。注意:此时还没有启用分页,所以直接用物理地址。

页表操作的重点是映射方法 map,它负责建立从虚拟地址到物理地址的映射,先来看基于 SV39 分页方案,MMU 映射的原理:

SV39 包含三级页表,寄存器 satp 保持着根页表(0 级)页表的基地址,当访问虚拟地址 VA 时,它的低 39 位有效,MMU 的工作过程:

- 截取虚拟地址 VA 的第 30 至 38 位总共 9 位,作为索引查询根页表,找到对应页表项,分析页表项的flags;

- 如果页表项包含的是下级页表,则重复 1 和 2 的过程,最后定位到目标物理页帧,VA 的低 12 位作为页内偏移,与物理页帧合成最终的物理地址,完成映射;

- 如果页表项就是 Leaf 节点 - 即大页映射,则直接把 VA 剩余部分作为页内偏移,合并成最终的物理地址,提前完成映射。SV39 可能包含的大页有两级,1G 粒度和 2M 粒度。

我们在页表上执行 map 操作的目的,就是设置页表去匹配上面 MMU 的工作机制。

第一节最后提到,本章我们只需要建立初始的地址空间,即只映射包含 SBI 和内核的 1G 区间范围。根页表(evel0 table)是通过 linker.lds 在内核布局中预留的一页,不用额外分配,剩下的工作就是建立这 1G 空间的直接映射和设置 satp 寄存器来启用页表。下面先解决映射的问题,下一节实现页表启用。

我们为地址空间映射设计一个名为 map 的方法,原型如下:

fn map(&mut self, mut va: usize, mut pa: usize, mut total_size: usize, best_size: usize, flags: usize);涉及五个参数:

- 地址范围在虚拟空间中的开始位置,即虚拟地址 va;

- 地址范围在物理空间中的开始位置,即物理地址 pa;

- 地址范围的总长度 total_size;

- 期望按照哪一级粒度进行映射,可以是第一级 1G,第二级 2M 或第三级 4K,用 best_size 表示。第二章第二节中,就是基于第一级建立的 1G 大页映射。这个是期望,不是强制的。前三个参数必须按照 best_size 对齐;

- 映射的标志位集合 flags,决定映射的有效性、权限等等。

当前阶段的映射函数 map 非常简单,就是建立 1G 空间从虚拟到物理的映射,并且映射涉及的虚拟地址 va 和物理地址 pa 都是按照 1G 对齐的,所以 best_size 直接就是 1G,这样省略了很多额外的处理过程。等到了第四章重建地址空间映射时,情况会复杂的多,到时候我们再讨论不对齐的情况。

当前 map 方法的具体实现:

// page_table/src/lib.rs

impl PageTable<'_> {

const fn entry_shift(&self) -> usize {

ASPACE_BITS - (self.level + 1) * (PAGE_SHIFT - 3)

}

const fn entry_size(&self) -> usize {

1 << self.entry_shift()

}

pub const fn entry_index(&self, va: usize) -> usize {

(va >> self.entry_shift()) & (ENTRIES_COUNT - 1)

}

pub fn map(&mut self, mut va: usize, mut pa: usize,

mut total_size: usize, best_size: usize, flags: usize

) -> PagingResult {

let entry_size = self.entry_size();

while total_size >= entry_size {

let index = self.entry_index(va);

if entry_size == best_size {

self.table[index].set(pa, flags);

} else {

let mut pt = self.next_table_mut(index)?;

pt.map(va, pa, entry_size, best_size, flags)?;

}

total_size -= entry_size;

va += entry_size;

pa += entry_size;

}

Ok(())

}

fn next_table_mut(&mut self, _index: usize) -> PagingResult<PageTable> {

unimplemented!();

}

}第 3~5 行:方法 entry_shift 用来计算当前页表的页表项粒度,以 2^shift^ 表示。对于 SV39,ASPACE_BITS 是 39 位,这样 0 级根页表的页表项覆盖范围就是 1G,1 级页表的页表项对应 2M。

第 6~8 行:基于 entry_shift,计算页表项 entry 以数值方式表示的覆盖范围。

第 9~11 行:基于 entry_shift,把虚拟地址 VA 转化为当前页表中的对应索引值。

第 13~35 行:方法 map 的基本实现。参数 total_size 代表要映射的总范围,参数 best_size 则指明我们希望映射粒度到哪一级,可选值是 1G、2M 和 4K,如果选前两个值会建立大页映射。具体实现时,分别处理了直接大页映射和建立下级页表的情况。对于建立下级页表 next_table_mut,需要动态内存分配功能的支持,这里只预留了函数框架,等到第四章再补全,本章实验不会执行到这里。

现在页表的基本机制已经建立了,下面通过一个组件级的测试用例,验证页表功能,本章我们只需要验证第一级映射(即 level 0)。

// page_table/tests/test_early.rs

use axconfig::SIZE_1G;

use page_table::{PageTable, PAGE_KERNEL_RWX};

#[test]

fn test_early() {

let boot_pt: [u64; 512] = [0; 512];

let mut pt: PageTable = PageTable::init(boot_pt.as_ptr() as usize, 0);

let _ = pt.map(0x8000_0000, 0x8000_0000, SIZE_1G, SIZE_1G, PAGE_KERNEL_RWX);

let _ = pt.map(0xffff_ffc0_8000_0000, 0x8000_0000, SIZE_1G, SIZE_1G, PAGE_KERNEL_RWX);

assert_eq!(boot_pt[2], 0x200000ef, "pgd[2] = {:#x}", boot_pt[2]);

assert_eq!(boot_pt[0x102], 0x200000ef, "pgd[0x102] = {:#x}", boot_pt[0x102]);

}在根目录下 Cargo.toml 中,members 中追加 "page_table",执行 make test 测试:

Running tests/test_early.rs (target/debug/deps/test_early-45021e16a6b88d19)

running 1 test test test_early ... ok

test result: ok. 1 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.00s

第三节 启用分页 - 进入虚拟地址空间

上一节中我们已经实现了组件 page_table,本节就基于它来启用分页,让内核从物理地址空间进入到虚拟地址空间。

两步完成地址空间的切换:

- 第一步:恒等映射保证虚拟空间与物理空间有一个相等范围的地址空间映射(0x80000000~0xC0000000)。切换前后地址范围不变,但地址空间其实已经从物理空间切换到虚拟空间;

- 第二步:给指令指针寄存器 pc,栈寄存器 sp 等加偏移,在图中该偏移是 0xffff_ffc0_0000_0000,即 PHYS_VIRT_OFFSET。通过在虚拟空间内地址平移,我们就完成了最终的地址映射。

以下扩展组件 axhal,在 RiscV64 架构下实现一个 paging 的模块,用于处理与分页管理相关的功能。

- 新增 paging 模块,在其中初始化启动阶段的页表:

// axhal/src/riscv64/paging.rs

use riscv::register::satp;

use axconfig::SIZE_1G;

use page_table::{PageTable, PAGE_KERNEL_RWX, phys_pfn};

extern "C" {

fn boot_page_table();

}

pub unsafe fn init_boot_page_table() {

let mut pt: PageTable = PageTable::init(boot_page_table as usize, 0);

let _ = pt.map(0x8000_0000, 0x8000_0000, SIZE_1G, SIZE_1G, PAGE_KERNEL_RWX);

let _ = pt.map(0xffff_ffc0_8000_0000, 0x8000_0000, SIZE_1G, SIZE_1G, PAGE_KERNEL_RWX);

}第 10~14 行:函数 init_boot_page_table 调用上一节 page_table 组件的功能来初始化页表,其中第 12 行建立恒等映射,第 13 行则是建立了最终的地址映射关系。这两行为上面所述的两步切换,进行了页表方面的准备。

- 继续在 paging 模块中,增加启用分页的功能函数 init_mmu:

// axhal/src/riscv64/paging.rs

pub unsafe fn init_mmu() {

let page_table_root = boot_page_table as usize;

satp::set(satp::Mode::Sv39, 0, phys_pfn(page_table_root));

riscv::asm::sfence_vma_all();

}第 4 行:针对 satp 寄存器,进行了两项配置,指定 Sv39 分页模式和指定根页表的物理页帧号;

第 5 行:刷新 TLB,确保此后 MMU 使用最新的页表。

- 注意要把 paging 模块加到 riscv64 模块下。

// axhal/src/riscv64.rs

mod paging;- 调整内核启动过程,插入初始化页表和启用分页的过程,修改后 _start() 的实现如下:

// axhal/src/riscv64/boot.rs

use crate::riscv64::paging;

#[no_mangle]

#[link_section = ".text.boot"]

unsafe extern "C" fn _start() -> ! {

// a0 = hartid

// a1 = dtb

core::arch::asm!("

mv s0, a0 // save hartid

mv s1, a1 // save DTB pointer

la a3, _sbss

la a4, _ebss

ble a4, a3, 2f

1:

sd zero, (a3)

add a3, a3, 8

blt a3, a4, 1b

2:

la sp, boot_stack_top // setup boot stack

call {init_boot_page_table} // setup boot page table

call {init_mmu} // enabel MMU

li s2, {phys_virt_offset} // fix up virtual high address

add sp, sp, s2 // readjust stack address

mv a0, s0 // restore hartid

mv a1, s1 // restore DTB pointer

la a2, {entry}

add a2, a2, s2 // readjust rust_entry address

jalr a2 // call rust_entry(hartid, dtb)

j .",

init_boot_page_table = sym paging::init_boot_page_table,

init_mmu = sym paging::init_mmu,

phys_virt_offset = const axconfig::PHYS_VIRT_OFFSET,

entry = sym super::rust_entry,

options(noreturn),

)

}第 21 行:调用 init_boot_page_table 初始化页表;

第 22 行:通过 init_mmu 启用 MMU 的分页机制;

第 23 行:在 s2 寄存器存放 PHYS_VIRT_OFFSET,后面用于调整栈指针与指令寄存器偏移;

第 24行:调整栈指针寄存器 sp,指向最终的虚拟地址位置;

第 27~29 行:第 27 行以相对寻址的方式去取得 rust_entry 地址,实际上该地址仍是之前的物理地址,在第 28 行加偏移调整后,才是最终的虚拟地址,第 29 行跳转后完成指令寄存器 PC 中运行地址的最终切换。

在上述工作之外,还有两项新增的工作:

第 10~11 行:通过 s0 和 s1 分别对 a0 和 a1 进行保存:a0 和 a1 保持着当前 CPU 的 ID 和 DTB 指针,保存是要防止后面的函数调用破坏它们。

第 25~26 行:从 s0 和 s1 寄存器中恢复 a0 和 a1,紧跟着再调用 rust_entry 时,它们会作为前两个参数传入 CPU_ID 和 DTB 指针。

- 修改 linker.lds,把 BASE_ADDRESS 从 0x80200000 改成 0xffffffc080200000。在分页机制启用的条件下,我们要求内核 Image 中的各种符号地址都以虚拟地址为准,确保将来符号地址寻址的正确性。

执行 make clean & make run,可以看到内核在完成地址空间切换后,启动成功了。但是单从屏幕输出,我们看不出区别,下面利用 qemu.log 确认我们的工作成果。

我们知道当前版本的内核调用 rust_entry 时,已经进入到虚拟地址空间。所以先查找 rust_entry 的符号地址:

riscv64-unknown-elf-objdump -t ./target/riscv64gc-unknown-none-elf/release/axorigin | grep rust_entry

输出结果:

ffffffc0802000a6 l F .text 0000000000000070 _ZN5axhal7riscv6410rust_entry17hde9b663f0cccf0f7E

发现它对应的地址是 0xffffffc0802000a6(同学们的实验环境中该值可能不同),然后进一步在 qemu.log 查找该地址:

----------------

IN:

Priv: 1; Virt: 0

0x000000008020008a: 12000073 sfence.vma zero,zero

0x000000008020008e: 8082 ret

----------------

IN:

Priv: 1; Virt: 0

0x000000008020003a: 597d addi s2,zero,-1

0x000000008020003c: 191a slli s2,s2,38

0x000000008020003e: 914a add sp,sp,s2

0x0000000080200040: 8522 mv a0,s0

0x0000000080200042: 85a6 mv a1,s1

0x0000000080200044: 00000617 auipc a2,0 # 0x80200044

0x0000000080200048: 06260613 addi a2,a2,98

0x000000008020004c: 964a add a2,a2,s2

0x000000008020004e: 9602 jalr ra,a2,0

----------------

IN:

Priv: 1; Virt: 0

0xffffffc0802000a6: 711d addi sp,sp,-96

0xffffffc0802000a8: ec86 sd ra,88(sp)

注意第 23 行,0xffffffc0802000a6 是 rust_entry 地址,基于前面的工作,当进入 rust_entry 时,此时的运行地址相对之前发生了明显变化,证明内核已经从物理地址空间切换到了虚拟地址空间。

第四节 早期内存分配器的设计

在 Rust 开发中,String、Vector 之类的各种复合类型为我们带来了很大便利。但是我们的内核目前还不支持,因为没有实现动态内存分配器。我们可以来尝试一下,把 axorigin 的 main 函数改成这样:

// axorigin/src/main.rs

#![no_std]

#![no_main]

extern crate alloc;

use alloc::string::String;

use axhal::ax_println;

#[no_mangle]

pub fn main(_hartid: usize, _dtb: usize) {

let s = String::from("from String");

ax_println!("\nHello, ArceOS![{}]", s);

}通过 make build 编译一下,报错:

error: no global memory allocator found but one is required; link to std or add `#[global_allocator]` to a static item that implements the GlobalAlloc trait

果然不支持,String 需要动态内存即堆管理的支持,普通 Rust 应用经由 STD 标准库去申请底层操作系统内核对内存分配的支持,但是我们本身就是在实现内核,所以只能自己实现,即 - 我们按照 Rust 框架要求,实现内核级的动态内存分配器。

内核级内存分配器需要满足两个方面的要求:

- 分配器必须实现 GlobalAlloc trait,如 String、Vector 等集合数据类型都需要基于这个 trait 定义接口对分配器发出要求,请求以字节为最小分配单位。

- 内核的很多功能都要求申请以页为基本单位,并且开始地址按页对齐的分配块。这种按页分配在内核开发中是十分常用和必要的,有必要作为独立的服务接口对外提供。

总结一下,功能上我们需要两种相互独立的内存分配器,一种基于字节分配,另一种基于页分配。

当前阶段,我们先采用最简单的设计方案,即让一个分配器同时支持两种分配功能。

分配机制:字节与页分配共用同一块内存空间,从前向后字节分配,从后向前页分配。它们分别使用一个指针维护当前到达的位置。

释放机制,同样采取最简单的策略:

- 针对字节分配,用 count 变量记录分配次数,仅在 count 回复到零时,才把当前位置指针重置成起始位置。也就是说,只有在所有申请的内存块全部释放时,才真正的释放空间。这样的内存使用效率当然不高,但在引导阶段这不是问题。

- 对于页分配,没有为它设计释放机制。一方面是为了简单,另一方面在早期内存分配器生效的这段时间,内核需要申请的页都是它这一生都需要的,所以并不需要释放。

建立新组件 axalloc 在内核中负责动态内存分配的功能。未来几章,我们将在该组件中定义一系列内存分配器,用于不同阶段和不同类型,本章首先定义早期内存分配器 EarlyAllocator:

// axalloc/src/lib.rs

#![no_std]

extern crate alloc;

mod early;

#[derive(Debug)]

pub enum AllocError {

InvalidParam,

MemoryOverlap,

NoMemory,

NotAllocated,

}

pub type AllocResult<T = ()> = Result<T, AllocError>;

// axalloc/src/early.rs

#![allow(dead_code)]

use core::alloc::Layout;

use core::ptr::NonNull;

use axconfig::{align_up, align_down, PAGE_SIZE};

use crate::{AllocResult, AllocError};

#[derive(Default)]

pub struct EarlyAllocator {

start: usize,

end: usize,

count: usize,

byte_pos: usize,

page_pos: usize,

}

impl EarlyAllocator {

pub fn init(&mut self, start: usize, size: usize) {

self.start = start;

self.end = start + size;

self.byte_pos = start;

self.page_pos = self.end;

}

pub const fn uninit_new() -> Self {

Self {

start: 0, end: 0, count: 0,

byte_pos: 0, page_pos: 0,

}

}

}

// axalloc/Cargo.toml

[dependencies]

axconfig = { path = "../axconfig" }第 33~38 行:指定地址范围初始化分配器,字节分配指针 byte_pos 和页分配指针 page_pos 的初始位置分别在两端。

第 17 行:目前临时加上 #![allow(dead_code)] 以屏蔽警告,等到正式引用 EarlyAllocator 时再取消这行。

然后是字节分配功能的实现:

// axalloc/src/early.rs

impl EarlyAllocator {

pub fn alloc_bytes(&mut self, layout: Layout) -> AllocResult<NonNull<u8>> {

let start = align_up(self.byte_pos, layout.align());

let next = start + layout.size();

if next > self.page_pos {

alloc::alloc::handle_alloc_error(layout)

} else {

self.byte_pos = next;

self.count += 1;

NonNull::new(start as *mut u8).ok_or(AllocError::NoMemory)

}

}

pub fn dealloc_bytes(&mut self, _ptr: NonNull<u8>, _layout: Layout) {

self.count -= 1;

if self.count == 0 {

self.byte_pos = self.start;

}

}

fn total_bytes(&self) -> usize {

self.end - self.start

}

fn used_bytes(&self) -> usize {

self.byte_pos - self.start

}

fn available_bytes(&self) -> usize {

self.page_pos - self.byte_pos

}

}第 3~13 行:字节分配方法,从前往后分配。首先对分配范围的开始位置对齐,然后计算结束位置并检查越界。注意:是否越界参照的是页分配指针 page_pos 指向的当前位置,而不是整个区域的结束位置。通过检查后,就把结束位置作为下次分配的开始搜索位置;另外,把 count 计数加一,用于记录已分配的块数。

第 15~20 行:字节释放方法,每释放一块就把计数 count 减一。当 count 减到 0 时,意味着之前分配的所有内存块都已经释放,字节分配指针回到初始位置。

第 22~30 行:监控字节分配率的三个方法,其中 available_bytes 是 page_pos 与 byte_pos 之间的区域长度。

执行 make test 先来测试一下字节分配的功能:

// axalloc/src/early.rs

#[cfg(test)]

mod tests;

// axalloc/src/early/tests.rs

use axconfig::PAGE_SIZE;

use core::alloc::Layout;

use super::EarlyAllocator;

#[test]

fn test_alloc_bytes() {

let space: [u8; PAGE_SIZE] = [0; PAGE_SIZE];

let base = space.as_ptr() as usize;

let mut early = EarlyAllocator::default();

early.init(base, PAGE_SIZE);

assert_eq!(early.total_bytes(), PAGE_SIZE);

assert_eq!(early.available_bytes(), PAGE_SIZE);

assert_eq!(early.used_bytes(), 0);

let layout = Layout::from_size_align(2, 2).unwrap();

let p0 = early.alloc_bytes(layout).unwrap();

assert_eq!(p0.as_ptr() as usize - base, 0);

assert_eq!(early.used_bytes(), 2);

let layout = Layout::from_size_align(4, 4).unwrap();

let p1 = early.alloc_bytes(layout).unwrap();

assert_eq!(p1.as_ptr() as usize - base, 4);

assert_eq!(early.used_bytes(), 8);

early.dealloc_bytes(p0, Layout::new::<usize>());

early.dealloc_bytes(p1, Layout::new::<usize>());

assert_eq!(early.total_bytes(), PAGE_SIZE);

assert_eq!(early.available_bytes(), PAGE_SIZE);

assert_eq!(early.used_bytes(), 0);

}从后向前是为页分配准备的区域,如前所述,在内核引导的早期申请的页面会一直使用,所以只需要实现 alloc_pages:

// axalloc/src/early.rs

impl EarlyAllocator {

pub fn alloc_pages(&mut self, layout: Layout) -> AllocResult<NonNull<u8>> {

assert_eq!(layout.size() % PAGE_SIZE, 0);

let next = align_down(self.page_pos - layout.size(), layout.align());

if next <= self.byte_pos {

alloc::alloc::handle_alloc_error(layout)

} else {

self.page_pos = next;

NonNull::new(next as *mut u8).ok_or(AllocError::NoMemory)

}

}

pub fn total_pages(&self) -> usize {

(self.end - self.start) / PAGE_SIZE

}

pub fn used_pages(&self) -> usize {

(self.end - self.page_pos) / PAGE_SIZE

}

pub fn available_pages(&self) -> usize {

(self.page_pos - self.byte_pos) / PAGE_SIZE

}

}第 4 行:页分配必须按页对齐。

第 5 行:从后向前查找可分配的页内存区,并且这个待分配内存区的开始地址必须按页对齐。

第 6~7 行:检查越界 - 新申请的页内存分配区域不能与现有的字节分配区域重叠。

第 9~10 行:在 page_pos 中记录当前分配到的位置,并成功返回内存块的地址。

第 14~22 行:跟踪页分配情况的三个方法,同样,注意 available_pages 对应的是 page_pos 和 byte_pos 之间的区域长度。

现在来验证页分配功能,执行测试 make test:

// axalloc/src/early/tests.rs

#[test]

fn test_alloc_pages() {

let num_pages = 16;

let total_size = PAGE_SIZE * num_pages;

let layout = Layout::from_size_align(total_size, PAGE_SIZE).unwrap();

let space = unsafe { alloc::alloc::alloc(layout) };

let start = space as usize;

let end = start + total_size;

let mut early = EarlyAllocator::default();

early.init(start, total_size);

assert_eq!(early.total_pages(), num_pages);

assert_eq!(early.available_pages(), num_pages);

assert_eq!(early.used_pages(), 0);

let layout = Layout::from_size_align(PAGE_SIZE, PAGE_SIZE).unwrap();

let p0 = early.alloc_pages(layout).unwrap();

assert_eq!(p0.as_ptr() as usize, end - PAGE_SIZE);

assert_eq!(early.used_pages(), 1);

let layout = Layout::from_size_align(PAGE_SIZE*2, PAGE_SIZE).unwrap();

let p1 = early.alloc_pages(layout).unwrap();

assert_eq!(p1.as_ptr() as usize, end - PAGE_SIZE*3);

assert_eq!(early.used_pages(), 3);

}本节我们为内核准备了一个早期引导过程中使用的动态内存分配器,它同时支持字节分配和页分配的功能。

但是该分配还没有启用,所以如果此时 make run 去运行本节开头的 axorigin 中的新代码,仍然会报同样的错误。下节我们来启用内存分配器,让内核初步支持动态内存分配。

第五节 启用动态内存分配

本节为内核启用动态内存分配功能,主要分两个步骤:

- 向 Rust 声明一个支持 GlobalAlloc Trait 的内存分配器 GlobalAllocator,这个 Trait 是向 Rust 提供动态内存分配服务的标准接口。

- 初始化内存分配器,为它指定可以使用的内存地址范围。

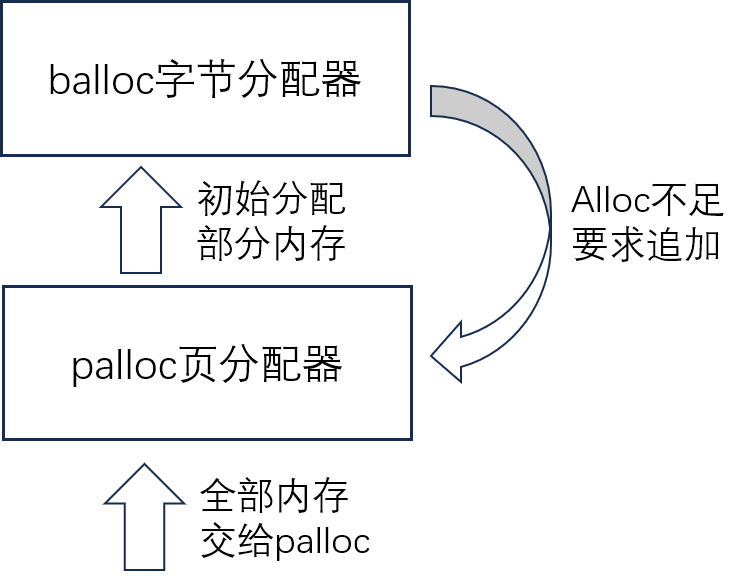

如上图,全局内存分配器 GlobalAllocator 实现 GlobalAlloc Trait,它包含两个功能:字节分配和页分配,分别用于响应对应请求。区分两种请求的策略是,请求分配的大小是页大小的倍数且按页对齐,就视作申请页;否则就是按字节申请分配。这两个内部功能可以由各种内存分配算法支持实现,当前是内核启动早期,我们基于上节提供的 early allocator支持两种功能。

全局内存分配器启用时必须指定一组可用的内存地址范围(至少一个)。在内核启动早期,通过 early_init 方法初始化并启用,这就是本节要实现的主要内容;然后在适当时刻,调用 final_init 方法切换到正式的内存分配器,这是第四章将要介绍的内容。

下面来实现全局内存分配器 GlobalAllocator,首先引入一些必须依赖的外部符号:

// axalloc/src/lib.rs

use core::alloc::Layout;

use core::ptr::NonNull;

use spinlock::SpinRaw;

use axconfig::PAGE_SIZE;

extern crate alloc;

use alloc::alloc::GlobalAlloc;

mod early;

use early::EarlyAllocator;实现全局的内存分配器:

// axalloc/src/lib.rs

#[cfg_attr(not(test), global_allocator)]

static GLOBAL_ALLOCATOR: GlobalAllocator = GlobalAllocator::new();

struct GlobalAllocator {

early_alloc: SpinRaw<EarlyAllocator>,

}

impl GlobalAllocator {

pub const fn new() -> Self {

Self {

early_alloc: SpinRaw::new(EarlyAllocator::uninit_new()),

}

}

pub fn early_init(&self, start: usize, size: usize) {

self.early_alloc.lock().init(start, size)

}

}分别为字节分配和页分配准备方法:

// axalloc/src/lib.rs

impl GlobalAllocator {

fn alloc_bytes(&self, layout: Layout) -> *mut u8 {

if let Ok(ptr) = self.early_alloc.lock().alloc_bytes(layout) {

ptr.as_ptr()

} else {

alloc::alloc::handle_alloc_error(layout)

}

}

fn dealloc_bytes(&self, ptr: *mut u8, layout: Layout) {

self.early_alloc.lock().dealloc_bytes(

NonNull::new(ptr).expect("dealloc null ptr"),

layout

)

}

fn alloc_pages(&self, layout: Layout) -> *mut u8 {

if let Ok(ptr) = self.early_alloc.lock().alloc_pages(layout) {

ptr.as_ptr()

} else {

alloc::alloc::handle_alloc_error(layout)

}

}

fn dealloc_pages(&self, _ptr: *mut u8, _layout: Layout) {

unimplemented!();

}

}现在如果进行编译,Rust 会提示需要 GlobalAlloc Trait,这个 Trait 是 GlobalAllocator 必须实现的标准接口。

实现 GlobalAlloc Trait 的两个方法 - 分配 alloc 和释放 dealloc,如下:

// axalloc/src/lib.rs

unsafe impl GlobalAlloc for GlobalAllocator {

unsafe fn alloc(&self, layout: Layout) -> *mut u8 {

if layout.size() % PAGE_SIZE == 0 && layout.align() == PAGE_SIZE {

self.alloc_pages(layout)

} else {

self.alloc_bytes(layout)

}

}

unsafe fn dealloc(&self, ptr: *mut u8, layout: Layout) {

if layout.size() % PAGE_SIZE == 0 && layout.align() == PAGE_SIZE {

self.dealloc_pages(ptr, layout)

} else {

self.dealloc_bytes(ptr, layout)

}

}

}

pub fn early_init(start: usize, len: usize) {

GLOBAL_ALLOCATOR.early_init(start, len)

}现在准备启用:

上一节开头,我们让 axorigin 向屏幕输出 String 类型,结果报错 - “没有全局内存分配器”。如下在使用 String 类型变量之前,首先对 axalloc 组件进行初始化,启用内存分配功能。

// axorigin/src/main.rs

#![no_std]

#![no_main]

extern crate alloc;

use alloc::string::String;

use axhal::ax_println;

#[no_mangle]

pub fn main(_hartid: usize, _dtb: usize) {

extern "C" {

fn _skernel();

}

// We reserve 2M memory range [0x80000000, 0x80200000) for SBI,

// but it only occupies ~194K. Split this range in half,

// requisition the higher part(1M) for early heap.

axalloc::early_init(_skernel as usize - 0x100000, 0x100000);

let s = String::from("from String");

ax_println!("\nHello, ArceOS![{}]", s);

}

// axorigin/Cargo.toml

[dependencies]

axhal = { path = "../axhal" }

axalloc = { path = "../axalloc" }第14~17行:如注释所述,我们使用内核前面 1M 的地址范围来初始化内存分配器,在 RiscV64 架构下这部分内存是确定空闲的。虽然只有 1M,但对于早期启动阶段来说已经足够了,第四章我们将切换到正式的内存分期器,管理所有的 Heap 区域。

在内核启动早期,我们不想直接使用内核后面的内存区域来初始化内存分配器。此时,内核尚未对系统的整体内存分布状况进行调查,还不知道具体有几块内存区域以及它们的大小,如直接使用可能会引入一些不确定因素。所以目前先使用确定的空闲区域初始化一个临时的小型的早期内存分配器,以方便后续引导过程的实现。

现在可以测试了,make run 看看输出结果:

Hello, ArceOS![from String]

验证成功!

第六节 内核分层和主干组件

前面我们已经启用了内存分配器组件 axalloc,对它的初始化工作临时放在了应用组件 axorigin 中。显然这是不合适的,内存分配器作为内核的关键组成部分应当划分到系统层,并在系统层就被初始化。但在此之前,我们将重新分析和规划整个系统的框架和分层。

回顾第一章的第三节,我们把系统简单分成了两层,应用层包含应用组件 axorigin,系统层仅包含硬件抽象组件 axhal。

实际上对于系统层,又可以进一步划分为硬件体系无关与硬件体系相关的两个层次。硬件体系相关的工作已经由 axhal 承担,现在我们再增加一级硬件体系无关的层次,该层的核心组件 axruntime 专门用来对通用的、硬件体系无关的各类组件进行组织和初始化。

此外,在应用层与系统层之间,常规上还需要一层应用接口库,负责封装屏蔽系统内部复杂性,方便应用的开发。其中关键组件 axstd,顾名思义,功能上相当于 Rust 官方 STD 库的作用。

这样系统就形成了如下的四层结构,每一层都由一个核心组件负责串联:

自底向上四个层次的核心组件分别是 axhal、axruntime、axstd 和 axorigin,它们构成了框架主干,在系统中是必须存在和不可替代的;除主干之外的其它组件都称为功能组件,往往是可选和可配置的,某些功能可能存在多个候选组件。由主干组件负责对功能组件进行接入、初始化和管理。

另外一个需要注意的问题:启动过程中,各层次主干组件的调用关系是自底向上,基于 extern ABI 的形式;而运行过程则是自顶向下调用,预先通过 Cargo.toml 中的 dependencies 建立依赖链。至于为何采用这样的设计,请回顾第一章第三节关于循环依赖的问题。

下面我们就将引入 axstd 和 axruntime 这两个新组件,并分别针对启动和运行两个过程对系统框架进行相应的调整。

启动过程的调整(自底向上)

先来改造 axhal,它的 rust_entry 中需要以 extern ABI 方式调用 axruntime 的 rust_main 入口:

// axhal/src/riscv64.rs

mod lang_items;

mod boot;

pub mod console;

mod paging;

unsafe extern "C" fn rust_entry(hartid: usize, dtb: usize) {

extern "C" {

fn rust_main(hartid: usize, dtb: usize);

}

rust_main(hartid, dtb);

}建立组件 axruntime 并实现它的主入口函数 rust_main,该函数未来将会包含内核启动的各个主要过程:

// axruntime/src/lib.rs

#![no_std]

pub use axhal::ax_println as println;

#[no_mangle]

pub extern "C" fn rust_main(_hartid: usize, _dtb: usize) -> ! {

extern "C" {

fn _skernel();

fn main();

}

println!("\nArceOS is starting ...");

// We reserve 2M memory range [0x80000000, 0x80200000) for SBI,

// but it only occupies ~194K. Split this range in half,

// requisition the higher part(1M) for early heap.

axalloc::early_init(_skernel as usize - 0x100000, 0x100000);

unsafe { main(); }

loop {}

}第 4 行:引入 axhal 定义的标准输出宏 ax_println,并且把它 re-export 出去,后面 axstd 将继续把它暴露给应用。

第 17 行:把对 axalloc 的初始化从应用 axorigin 中转移到 rust_main 中。

第 18 行:调用 axorigin 的入口 main。

然后是对应调整 axorigin 的 main 函数:

// axorigin/src/main.rs

#![no_std]

#![no_main]

use axstd::{String, println};

#[no_mangle]

pub fn main(_hartid: usize, _dtb: usize) {

let s = String::from("from String");

println!("\nHello, ArceOS![{}]", s);

}第 5 行:应用只与接口库 axstd 交互,使用它提供的类型、方法及宏,所以我们将让 axstd 公开这些声明。

运行过程的调整(自顶向下)

建立从 axorigin -> axstd -> axruntime -> axhal 的依赖关系:

# axorigin/Cargo.toml

[dependencies]

axstd = { path = "../axstd" }

# axstd/Cargo.toml

[dependencies]

axruntime = { path = "../axruntime" }

axhal = { path = "../axhal" }

# axruntime/Cargo.toml

[dependencies]

axhal = { path = "../axhal" }

axalloc = { path = "../axalloc" }

第 12 行:axruntime 负责初始化 axalloc,建立对它的依赖。

应用接口库组件 axstd 的实现:

// axstd/src/lib.rs

#![no_std]

extern crate alloc;

pub use alloc::string::String;

pub use axruntime::println;第 5 行:直接 re-export Rust 的 alloc 库中定义的 String 类型。

第 6 行:把 axruntime 声明的 println 宏公开给应用层调用。

上述 5 和 6 行的目的都是尽可能简化应用开发,让开发者获得类似于在 Linux/Windows 上开发 Rust 应用的体验。

代码调整完毕,但还需要更新一下测试方面的设置。新增 axruntime 和 axstd 组件后,make test 在遇到这两个组件时,会报错。

我们对内核的测试主要针对各个功能组件,所以屏蔽 axruntime 和 axstd 组件,以减少测试过程中不必要的干扰:

# Makefile

test:

cargo test --workspace --exclude "axorigin" --exclude "axruntime" --exclude "axstd" -- --nocapture

看一下当前根目录下的 Cargo.toml 内容:

[workspace]

resolver = "2"

members = [

"axorigin", "axhal", "axconfig", "spinlock", "axsync", "page_table", "axalloc",

"axruntime", "axstd",

]

[profile.release]

lto = true

现在可以执行测试,看我们最近对内核的修改是否影响了之前的功能。

执行 make test:测试全部通过!

最后验证整个内核在调整整体框架后的功能,执行 make run,看结果:

ArceOS is starting ...

Hello, ArceOS![from String]

输出正常!

本章总结

本章我们首先引入了地址空间的概念,设计了内核在早期引导过程中的地址空间布局。然后按照布局要求,建立了最初的页表,并基于 RiscV64 硬件机制启用分页,进入到虚拟地址空间,为后面各种功能组件的初始化和运行建立了基础。为了让后面的内核开发过程可以使用 Rust 提供的高级类型,我们建立了早期的内存分配器,虽然它的最大分配能力只有 1M,但是已经足以支撑内核的早期启动工作。等我们能够通过解析 fdt 信息获取实际的物理内存大小之后,将会构建并切换到正式的内存分配器。最后,我们引入了 axruntime 和 axstd 这两个组件,形成了典型的四层系统架构,现在内核的主干框架已经齐备,后面我们将基于这个框架不断扩展功能组件,逐步接近设计目标。

第三章 基础组件 - 时间、日志和设备树

【正式启动前的准备】

通过前面几章的实验,我们的内核已经初具雏形,但是仍然欠缺一些基础设施,包括时间、日志以及设备树解析器等等。它们对下一步继续扩展内核的各个子系统,将会起到重要的支撑作用。

第一节 获得系统时间

系统时间是支持内核运行最重要的基础之一,也是应用需要获取的重要服务之一。获取系统时间必须基于硬件平台提供的时间寄存器,它们本质上就是由晶振驱动的计数器。对 RiscV64 来说,在 M-Mode 有一个专门的计数寄存器 mtime 作为计算时间的基础,它在 S-Mode 被映射为名为 time 的寄存器,所以内核虽然运行在 S-Mode,也可以读出该寄存器的值。按照规范文档的说法,time 是 mtime 的 shadow。

既然获取系统时间是体系结构相关的功能,我们把它放到 axhal 中实现。

// axhal/src/riscv64/time.rs

use core::time::Duration;

use riscv::register::time;

const TIMER_FREQUENCY: u64 = 10_000_000; // 10MHz

const NANOS_PER_SEC: u64 = 1_000_000_000;

const NANOS_PER_TICK: u64 = NANOS_PER_SEC / TIMER_FREQUENCY;

pub type TimeValue = Duration;

#[inline]

pub fn current_ticks() -> u64 {

time::read() as u64

}

#[inline]

pub const fn ticks_to_nanos(ticks: u64) -> u64 {

ticks * NANOS_PER_TICK

}

pub fn current_time_nanos() -> u64 {

ticks_to_nanos(current_ticks())

}

pub fn current_time() -> TimeValue {

TimeValue::from_nanos(current_time_nanos())

}

// axhal/src/riscv64.rs

pub mod time;第18行:核心函数 current_ticks(),返回 ticks 计数值;其他函数都以它为基础进行计算。

第22行:对外提供时间服务的主要函数。无论是内核模块还是应用接口库都是经由它获取系统时间。

本节我们先来扩展 axstd,参照 Rust 官方 STD 库的实现方式,提供 Instant 类型和相关方法,向应用提供时间功能:

// axstd/src/time.rs

use core::time::Duration;

use core::ops::Sub;

use core::fmt;

#[derive(Clone, Copy)]

pub struct Instant(axhal::time::TimeValue);

impl Instant {

pub fn now() -> Instant {

Instant(axhal::time::current_time())

}

pub fn elapsed(&self) -> Duration {

Instant::now() - *self

}

pub fn duration_since(&self, earlier: Instant) -> Duration {

self.0.checked_sub(earlier.0).unwrap_or_default()

}

}

impl Sub<Instant> for Instant {

type Output = Duration;

fn sub(self, other: Instant) -> Self::Output {

self.duration_since(other)

}

}

impl fmt::Display for Instant {

fn fmt(&self, f: &mut fmt::Formatter) -> fmt::Result {

write!(f, "{}.{:06}", self.0.as_secs(), self.0.subsec_micros())

}

}

// axstd/src/lib.rs

pub mod time;

pub use time::*;现在,我们可以在应用 axorigin 中,测试一下获取时间的功能:

// axorigin/src/main.rs

#![no_std]

#![no_main]

use axstd::{String, println, time};

#[no_mangle]

pub fn main(_hartid: usize, _dtb: usize) {

let now = time::Instant::now();

println!("\nNow: {}", now);

let s = String::from("from String");

println!("Hello, ArceOS![{}]", s);

let d = now.elapsed();

println!("Elapsed: {}.{:06}", d.as_secs(), d.subsec_micros());

}执行 make run 测试,显示结果:

ArceOS is starting ...

Now: 0.103643 Hello, ArceOS![from String] Elapsed: 0.003917

获取时间功能验证成功!

第二节 组件 crate_interface - 打破循环依赖

在基于 Rust 语言开发时,可以通过引用现有的 crate 来引入其功能,基本方式就是在 Cargo.toml 中建立对外部 crate 的依赖,然后就可以像引用内部模块一样调用它的代码。但是这种方式是有局限性的,如果两个 crate 之间存在相互依赖,或者多个 crate 存在环形依赖,都会阻碍编译。我们称这种问题为循环依赖。

我们的内核基于组件化思想并且采用 Rust 语言实现,在这种开发条件下,crate 是作为组件的实现形式。在后面的开发过程中,我们将经常会遇到循环依赖的问题,例如下节将要引入的 axlog 日志组件:

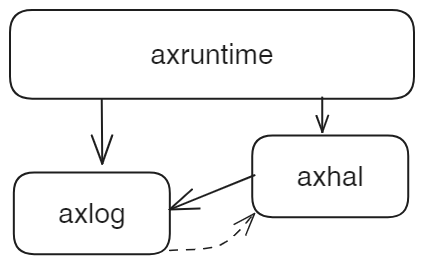

组件 axruntime 在初始化时,将会初始化 axhal 和 axlog 这两个组件。对于 axhal 和 axlog 这两个组件来说,一方面,axhal 组件需要日志功能,所以依赖 axlog 组件;与此同时,axlog 必须依赖 axhal 提供的标准输出或写文件功能以实现日志输出,所以 axlog 又反过来依赖 axhal。这就在二者之间形成了循环依赖。所以我们必须想办法替换其中一个方向的依赖,以打破循环依赖。

在 Rust 开发中,还存在一种 extern ABI 的机制,见 Rust 参考手册External blocks - The Rust Reference (rust-lang.org) 中关于 ABI 的那一节。形式上采用 extern "Rust" 来声明外部函数,随后就可以在当前 crate 中直接调用该函数。本质上这是一种在低级的 ABI 层面进行符号引用的方法,好处是不用在 Cargo.toml 中定义依赖,可以跳出循环依赖的限制;但是不利之处在于,它是 unsafe 方式,Rust 不做参数正确性检查,不保证其安全性。

为了提高上述方式的可读和易用性,降低编码出错的可能,我们创建一个组件 crate_interface,基于一组过程宏 proc_macro 来封装 extern ABI 的机制。以后在我们的内核开发中,将会经常用到这个组件。

下面仍然以 axhal 和 axlog 为例,说明 crate_interface 的用法。我们选择让 axhal 通过 Cargo.toml 的 [dependencies] 对 axlog 建立依赖,而 axlog 对 axhal 的反向引用基于 crate_interface 提供的机制,如下图:

-

通过 #[def_interface] 宏,在 axlog 中定义一个跨 crate 的接口 LogIf

接口 LogIf 包含调用方和实现方交互的两个具体方法,分别是写字符串 write_str() 和获取当前时间 get_time()。为方便,直接把 LogIf 定义在 axlog 中。

// axlog/src/lib.rs #![no_std] #[crate_interface::def_interface] pub trait LogIf { fn write_str(s: &str); fn get_time() -> core::time::Duration; } // axlog/Cargo.toml [dependencies] crate_interface = "0.1.1"第 4 行:过程宏 crate_interface::def_interface 在预编译的过程中,对 Trait LogIf 的声明进行处理。

预编译处理后,形成如下形式的代码。

extern "Rust" { fn __LogIf_write_str(s: &str); fn __LogIf_get_time() -> core::time::Duration; }可以看到,实际上就是声明了一组 extern "Rust" 的外部函数,每个函数对应 LogIf 的一个方法,函数名是接口名+对应方法名。这样将来在引入了 LogIf 接口的代码文件中,就可以调用这些外部函数了。当然我们不需要直接调用,继续看下面的封装。

-

在 axhal 中定义 LogIfImpl 实现 LogIf 接口,并通过 #[impl_interface] 宏进行标记,说明它是一个跨 crate 的接口实现:

// /axhal/src/riscv64.rs struct LogIfImpl; #[crate_interface::impl_interface] impl axlog::LogIf for LogIfImpl { fn write_str(s: &str) { console::write_bytes(s.as_bytes()); } fn get_time() -> core::time::Duration { time::current_time() } } // axhal/Cargo.toml [dependencies] axconfig = { path = "../axconfig" } page_table = { path = "../page_table" } axlog = { path = "../axlog" } crate_interface = "0.1.1"第 4 行:过程宏 crate_interface::impl_interface 在预编译阶段,处理第 5 到第 13 行的 LogIfImpl 实现。

效果是新增了如下形式的代码:

extern "Rust" { fn __LogIf_write_str(s: &str) { let IMPL: LogIfImpl = LogIfImpl; IMPL.write_str(s) } fn __LogIf_get_time() -> core::time::Duration { let IMPL: LogIfImpl = LogIfImpl; IMPL.get_time() } }实际就是生成了两个框架函数 __LogIf_write_str 和 __LogIf_get_time,符号名与 def_interface 生成的两个外部函数声明是对应一致的。它们同样是放在 extern "Rust" 代码块中,将作为跨 crate 的符号使用。当其它 crate 调用这两个框架函数时,它们在内部生成 LogIfImpl 的临时实例,并调用其对应的实现方法。

-

通过宏 call_interface!(LogIf::XXX) 调用 LogIf 的实现

在 axlog 中定义函数 init(),在其中通过

call_interface!这个宏去调用接口 LogIf,如下:pub fn init() { extern crate alloc; let now = crate_interface::call_interface!(LogIf::get_time()); let s = alloc::format!("Logging startup time: {}.{:06}", now.as_secs(), now.subsec_micros()); crate_interface::call_interface!(LogIf::write_str(s.as_str())); }第 4 行:call_interface! 宏调用 LogIf::get_time,预编译后该宏被替换为如下形式的代码:

unsafe { __LogIf_get_time() }第 7 行:call_interface! 宏调用 LogIf::write_str,预编译后该宏被替换为如下形式的代码:

unsafe { __LogIf_write_str(s) }也就是说第 4 和第 7 行会转化为对这两个跨 crate 外部函数的调用。回顾前面的第 1 项已经通过 def_interface 宏处理 LogIf,声明了这两个符号,这里直接调用即可。最后,Rust 链接器会对调用方和实现方的符号进行链接,由此在 ABI 层面完成调用关系的建立。

-

下面来验证 crate_interface 的功能。

在 axruntime 组件的初始化过程中,初始化 axlog。

//axruntime/src/lib.rs #[no_mangle] pub extern "C" fn rust_main(_hartid: usize, _dtb: usize) -> ! { extern "C" { fn _skernel(); fn main(); } println!("\nArceOS is starting ..."); // We reserve 2M memory range [0x80000000, 0x80200000) for SBI, // but it only occupies ~194K. Split this range in half, // requisition the higher part(1M) for early heap. axalloc::early_init(_skernel as usize - 0x100000, 0x100000); axlog::init(); unsafe { main(); } loop {} } // axruntime/Cargo.toml [dependencies] axhal = { path = "../axhal" } axalloc = { path = "../axalloc" } axlog = { path = "../axlog" }注意:第 16 行调用 axlog::init() 中需要动态申请内存,所以它必须放在第 14 行 axalloc::early_init 动态内存初始化之后。

执行

make run,查看结果:ArceOS is starting ... Logging startup time: 0.122987 Now: 0.126629 Hello, ArceOS![from String] Elapsed: 0.001787

上面打印了 logging 成功启动的信息!当然本节主要目标是介绍 crate_interface 组件,axlog 只是作为示例引入,下一节我们将会给出 axlog 组件的完整实现。

最后来总结一下,组件 crate_interface 实现了如下的效果:

基于预定义的接口 trait,在任意 crate 中对该接口的功能实现,可以被其它任意 crate 中的代码所调用。实现方和调用方之间在 ABI 层完成链接,不需要通过 Cargo.toml 建立依赖就可以实现跨 crate 的接口调用,可以跳出循环依赖的限制。

第三节 组件 axlog - 支持 log

现在我们来为内核正式实现日志组件 axlog。在 crates.io 中已经有一个非常通用的日志 crate - log,它主要用于普通应用的开发;本节我们将以它为基础进行封装和扩展,满足内核对日志设施的需要。

首先实现日志的初始化过程和级别设置:

// axlog/Cargo.toml

[dependencies]

log = "0.4"

crate_interface = "0.1.1"

// axlog/src/lib.rs

#![no_std]

use core::fmt::{self, Write};

use core::str::FromStr;

use crate_interface::call_interface;

use log::{Level, LevelFilter, Log, Metadata, Record};

pub use log::{debug, error, info, trace, warn};

#[crate_interface::def_interface]

pub trait LogIf {

fn write_str(s: &str);

fn get_time() -> core::time::Duration;

}

struct Logger;

pub fn init() {

log::set_logger(&Logger).unwrap();

log::set_max_level(LevelFilter::Warn);

}

pub fn set_max_level(level: &str) {

let lf = LevelFilter::from_str(level).ok().unwrap_or(LevelFilter::Off);

log::set_max_level(lf);

}第 4 行:Cargo.toml 引入 log 和 crate_interface 两个 crates。

第 21 行:全局的日志实例 Logger,它代表了日志对象,将来对日志的各种操作主要都是针对它。

第 23~26 行:上一节 init() 的实现仅是为了测试 crate_interface,这里重新实现。先是指定日志对象,然后设置默认日志级别 warn。

第 28~31 行:控制日志级别 set_max_level,支持关闭 off 以及 error, warn, info, debug, trace5 个级别。默认是 warn 级,即默认情况下只输出警告与错误。

然后,最重要的一步,按照 crate log 的实现要求,为 Logger 实现 trait Log 接口。这个外部的 crate log 本身是一个框架,实现了日志的各种通用功能,但是如何对日志进行输出需要基于所在的环境,这个 trait Log 就是通用功能与环境交互的接口。

下面列出实现 Log 接口的具体逻辑:

macro_rules! with_color {

($color_code:expr, $($arg:tt)*) => {{

format_args!("\u{1B}[{}m{}\u{1B}[m", $color_code as u8, format_args!($($arg)*))

}};

}

#[repr(u8)]

#[allow(dead_code)]

enum ColorCode {

Red = 31, Green = 32, Yellow = 33, Cyan = 36, White = 37, BrightBlack = 90,

}

impl Log for Logger {

#[inline]

fn enabled(&self, _metadata: &Metadata) -> bool {

true

}

fn log(&self, record: &Record) {

let level = record.level();

let line = record.line().unwrap_or(0);

let path = record.target();

let args_color = match level {

Level::Error => ColorCode::Red,

Level::Warn => ColorCode::Yellow,

Level::Info => ColorCode::Green,

Level::Debug => ColorCode::Cyan,

Level::Trace => ColorCode::BrightBlack,

};

let now = call_interface!(LogIf::get_time);

print_fmt(with_color!(

ColorCode::White,

"[{:>3}.{:06} {path}:{line}] {args}\n",

now.as_secs(),

now.subsec_micros(),

path = path,

line = line,

args = with_color!(args_color, "{}", record.args()),

));

}

fn flush(&self) {}

}第 1~11 行:为日志输出功能准备一个宏 with_color 和颜色代码,后面将根据级别为日志文本增加不同的颜色。

第 13~17 行:是否启用日志功能,硬编码启用即可。

第 19~41 行:Log::log 方法是关键,准备好显示颜色、当前时间、当前模块路径、行号以及日志内容等一系列参数,然后调用 print_fmt 执行日志的输出功能。

第 43 行:flush 刷新日志缓存。我们内核日志目前只是打印到屏幕,不涉及刷新,所以忽略。

下一步来看 print_fmt 的具体实现:

impl Write for Logger {

fn write_str(&mut self, s: &str) -> fmt::Result {

call_interface!(LogIf::write_str, s);

Ok(())

}

}

pub fn print_fmt(args: fmt::Arguments) {

let _ = Logger.write_fmt(args);

}第 1~6 行:为 Logger 实现 Write trait,目的是借助 Rust 提供的这个 trait,完成从变参到最终字符串的转换。我们只需要实现 write_str 方法,输入参数已经是处理好的结果字符串,然后通过 call_interface 调用 axhal 中实现的 LogIf::write_str 来完成日志输出。

第 8~10 行:print_fmt 的实现。既然 Logger 已经实现了 Write trait,我们只需要调用 Logger 的 write_fmt 方法,Logger 就会自动处理变参,进而如上面所述,通过 write_str 进行输出。

上面已经完成了 axlog 的实现,下面在 axruntime 中初始化 axlog,并尝试打印两行日志:

#![no_std]

pub use axhal::ax_println as println;

#[macro_use]

extern crate axlog;

#[no_mangle]

pub extern "C" fn rust_main(hartid: usize, dtb: usize) -> ! {

extern "C" {

fn _skernel();

fn main();

}

println!("\nArceOS is starting ...");

// We reserve 2M memory range [0x80000000, 0x80200000) for SBI,

// but it only occupies ~194K. Split this range in half,

// requisition the higher part(1M) for early heap.

axalloc::early_init(_skernel as usize - 0x100000, 0x100000);

axlog::init();

axlog::set_max_level(option_env!("LOG").unwrap_or(""));

info!("Logging is enabled.");

info!("Primary CPU {} started, dtb = {:#x}.", hartid, dtb);

unsafe { main(); }

loop {}

}第 22 行:初始化 axlog 组件。上节已经实现这行。

第 23 行:通过 make 传入外部环境变量 LOG,指定日志级别。

第 24~25 行:打印两行日志到屏幕。

执行 make run LOG=info 验证 axlog 是否能够完成日志初始化和 info 级别的日志输出:

ArceOS is starting ... [ 0.098586 axruntime:24] Logging is enabled. [ 0.103594 axruntime:25] Primary CPU 0 started, dtb = 0x87000000.

Now: 0.107696 Hello, ArceOS![from String] Elapsed: 0.002323

在屏幕输出中显示了我们记录的 info 日志,axlog 验证成功!

之前我们的内核已经实现了一个最简单的 panic,处理方式就是进入无限循环等待。本节来完善对它的实现。

// axhal/src/riscv64/lang_items.rs

use axlog::error;

#[panic_handler]

fn panic(info: &PanicInfo) -> ! {

error!("{}", info);

axhal::misc::terminate()

}很简单,先打印错误信息日志,然后内核中止运行。对于中止运行这个功能,我们需要扩展一下 axhal 组件。

// axhal/src/riscv64/misc.rs

pub fn terminate() -> ! {

sbi_rt::system_reset(sbi_rt::Shutdown, sbi_rt::NoReason);

loop {}

}

// axhal/src/riscv64.rs

mod misc;

pub use misc::terminate;既然有了 terminate 功能,我们把 axruntime 的 rust_main 函数最后一行 loop {},直接替换为 terminate(),如下:

// axruntime/src/lib.rs

#[no_mangle]

pub extern "C" fn rust_main(hartid: usize, dtb: usize) -> ! {

... ...

unsafe { main(); }

axhal::terminate();

}再次执行 make run,查看执行结果:

ArceOS is starting ...

Now: 0.098169 Hello, ArceOS![from String] Elapsed: 0.003439

结果显示没有变化,但是内核执行完毕后自动就退出了,不再需要 ctrl + A +X 退出 qemu,方便了以后对内核的开发测试。

第四节 组件 axdtb - 操作设备树

在第二章的第一节中,我们已经学习了如何通过 qemu 命令行,导出平台的配置信息。

这一节来到了内核在启动早期的一个重要环节,让内核自己解析 fdt 设备树来获得硬件平台的配置情况,作为后面启动过程的基础。

回顾一下,内核最初启动时从 SBI 得到两个参数分别在 a0 和 a1 寄存器中。其中 a1 寄存器保存的是 dtb 的开始地址,而 dtb 就是 fdt 的二进制形式,它的全称 device tree blob。由于它已经在内存中放置好,内核启动时就可以直接解析它的内容获取信息。

首先来了解一下标准 dtb 文件的布局规定:

我们内核要解析的 dtb 内存块实际就是 dtb 文件在内存中的映射,主要包含四个部分:

- 头结构 header:固定长度和格式,保存着全局信息和后面各个部分的相对偏移,所以解析 header 是解析整个 dtb 的第一步。

- 保留的内存区域信息:这部分我们暂时用不到。跳过。

- 主体结构:dtb 主体是由 Node 构成的树型结构,每个 Node 可以有自己的 properties。这个是我们要解析的主体,后面重点说明。

- 字符串表:一系列将被 Node 引用的字符串信息,由于每个字符串都是不定长的,所以把它们集中归置成一个块,并放到最后。

下面开始创建 axdtb 组件,首先给出解析设备树所需的常量和错误定义:

// axdtb/src/lib.rs

#![no_std]

use core::str;

use axconfig::align_up;

mod util;

pub use crate::util::SliceRead;

extern crate alloc;

use alloc::{borrow::ToOwned, string::String, vec::Vec};

const MAGIC_NUMBER : u32 = 0xd00dfeed;

const SUPPORTED_VERSION: u32 = 17;

const OF_DT_BEGIN_NODE : u32 = 0x00000001;

const OF_DT_END_NODE : u32 = 0x00000002;

const OF_DT_PROP : u32 = 0x00000003;

#[derive(Debug)]

pub enum DeviceTreeError {

BadMagicNumber,

SliceReadError,

VersionNotSupported,

ParseError(usize),

Utf8Error,

}

pub type DeviceTreeResult<T> = Result<T, DeviceTreeError>;第 13~17 行:规范对设备树文件中各个常量的定义。

第 19~28 行:解析设备树过程中需要的错误类型定义。

定义 DeviceTree 作为主类型:

// axdtb/src/lib.rs

pub struct DeviceTree {

ptr: usize,

totalsize: usize,

pub off_struct: usize,

off_strings: usize,

}

impl DeviceTree {

pub fn init(ptr: usize) -> DeviceTreeResult<Self> {

let buf = unsafe {

core::slice::from_raw_parts(ptr as *const u8, 24)

};

if buf.read_be_u32(0)? != MAGIC_NUMBER {

return Err(DeviceTreeError::BadMagicNumber)

}

if buf.read_be_u32(20)? != SUPPORTED_VERSION {

return Err(DeviceTreeError::VersionNotSupported);

}

let totalsize = buf.read_be_u32(4)? as usize;

let off_struct = buf.read_be_u32(8)? as usize;

let off_strings = buf.read_be_u32(12)? as usize;

Ok(

Self {ptr, totalsize, off_struct, off_strings}

)

}

}第 2~7 行:定义设备树的数据结构 DeviceTree,其中 ptr 和 totalsize 保持 dtb 内存块开始地址和总长度,另外两个成员分别是主体结构和字符串表的偏移。整个 DeviceTree 结构实际就对应于 dtb header。

第 10~29 行:初始化方法 init(),解析 dtb header,首先校验 magic 和版本,然后取出 header 的基本信息填充 DeviceTree 实例。

完成 header 信息解析后,后面主要的任务就是通过 off_struct 标记的偏移,解析 dtb 主体结构。前面提到,dtb 主体结构是一个由 Node 构成的树型结构,来看一下这棵树的示意图:

每一个节点 Node 由两部分组成,属性列表 properties 和子节点 Node 列表。每个属性 property 是 key - value 的形式。每个子节点重复上述的构成。从实现的角度,我们当然可以定义 Node 的数据结构,并在解析 dtb 时申请内存构建 Node 实例,如此逐渐构成一棵树,这样以后就可以随时遍历它获取目标信息。但是这种方式比较耗费内存资源,而我们内核目前只能使用 1M 的动态内存堆,所以考虑了另外一种方案:从 dtb 根节点开始,进行一次性的深度优先递归遍历,每遍历到一个节点 Node,就把它的信息传递给一个回调函数(闭包)处理。这种方案比较节省内存,并且目前不需要定义 Node 数据结构,我们在调用回调函数时,可以直接把 Node 的各个属性直接传入。

回调闭包的形式是 FnMut(String, usize, usize, Vec<(String, Vec<u8>)>,四个参数按顺序分别是节点 Node 的名称、#address-cells、#size-cells 和属性列表,每个属性都是名值对形式。关于 #address-cells 和 #size-cells,它们用于指明如何解释当前 Node 及下级 Node 的 reg 属性,在第二章第一节已经说明了它们的作用。

下面来实现解析 dtb 主体部分的方法 parse:

// axdtb/src/lib.rs

impl DeviceTree {

pub fn parse(

&self, mut pos: usize,

mut addr_cells: usize,

mut size_cells: usize,

cb: &mut dyn FnMut(String, usize, usize, Vec<(String, Vec<u8>)>)

) -> DeviceTreeResult<usize> {

let buf = unsafe {

core::slice::from_raw_parts(self.ptr as *const u8, self.totalsize)

};

// check for DT_BEGIN_NODE

if buf.read_be_u32(pos)? != OF_DT_BEGIN_NODE {

return Err(DeviceTreeError::ParseError(pos))

}

pos += 4;

let raw_name = buf.read_bstring0(pos)?;

pos = align_up(pos + raw_name.len() + 1, 4);

// First, read all the props.

let mut props = Vec::new();

while buf.read_be_u32(pos)? == OF_DT_PROP {

let val_size = buf.read_be_u32(pos+4)? as usize;

let name_offset = buf.read_be_u32(pos+8)? as usize;

// get value slice

let val_start = pos + 12;

let val_end = val_start + val_size;

let val = buf.subslice(val_start, val_end)?;

// lookup name in strings table

let prop_name = buf.read_bstring0(self.off_strings + name_offset)?;

let prop_name = str::from_utf8(prop_name)?.to_owned();

if prop_name == "#address-cells" {

addr_cells = val.read_be_u32(0)? as usize;

} else if prop_name == "#size-cells" {

size_cells = val.read_be_u32(0)? as usize;

}

props.push((prop_name, val.to_owned()));

pos = align_up(val_end, 4);

}

// Callback for parsing dtb

let name = str::from_utf8(raw_name)?.to_owned();

cb(name, addr_cells, size_cells, props);

// Then, parse all its children.

while buf.read_be_u32(pos)? == OF_DT_BEGIN_NODE {

pos = self.parse(pos, addr_cells, size_cells, cb)?;

}

if buf.read_be_u32(pos)? != OF_DT_END_NODE {

return Err(DeviceTreeError::ParseError(pos))

}

pos += 4;

Ok(pos)

}

}

impl From<str::Utf8Error> for DeviceTreeError {

fn from(_: str::Utf8Error) -> DeviceTreeError {

DeviceTreeError::Utf8Error

}

}第 4 行:参数 pos 从 off_struct 开始,跟踪当前解析到达的位置;